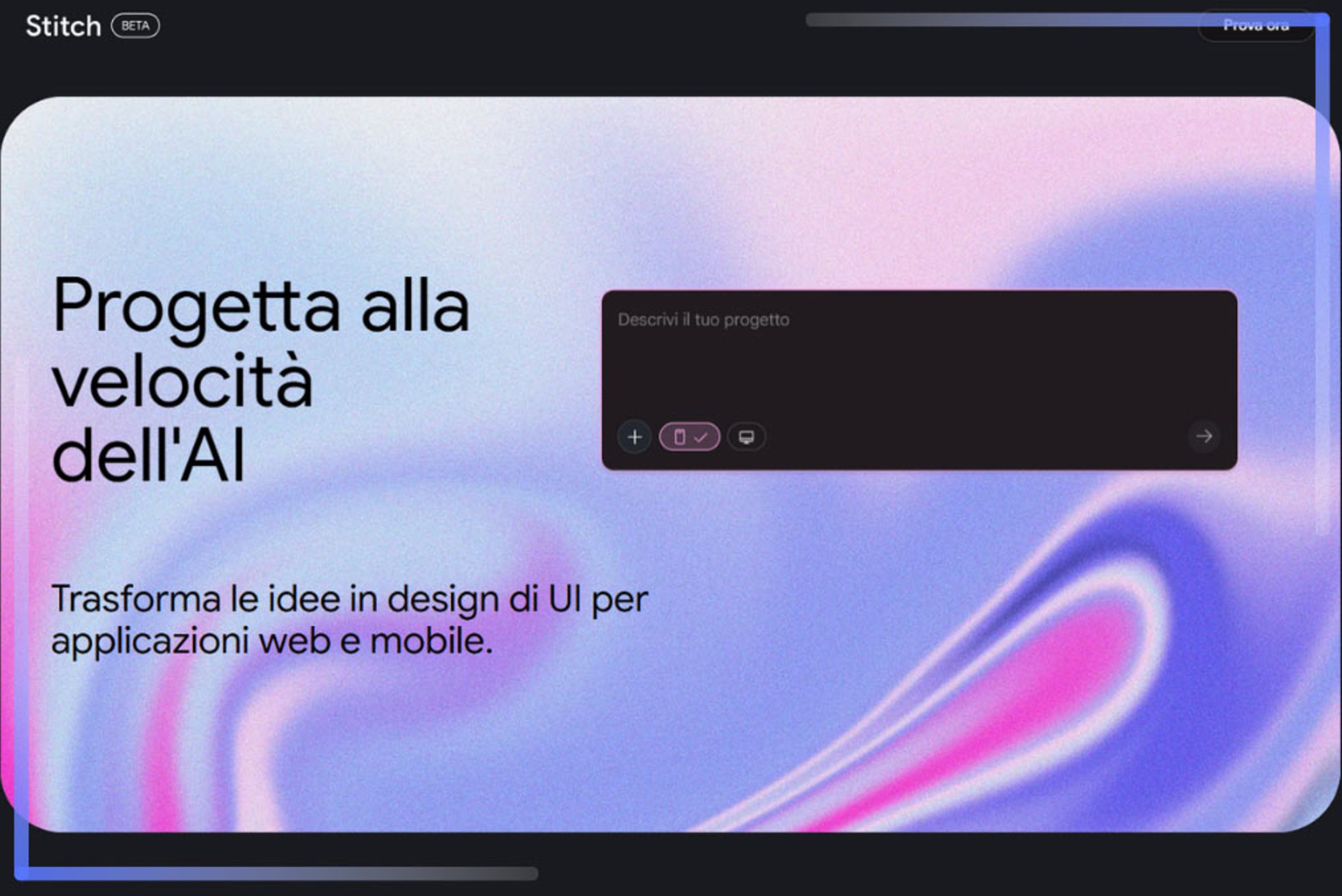

Hai mai sentito parlare di Google Stitch? Risale a qualche mese fa la notizia del nuovo strumento sperimentale di AI generativa by Google, capace di trasformare una descrizione testuale o un wireframe in un’interfaccia completa. In poche parole, un prompt testuale come “crea una pagina di login essenziale con pulsante di CTA” si concretizza in un layout strutturato, pronto per essere modificato o esportato in codice. È così che il linguaggio naturale diventa parte integrante del processo di design.

Possiamo considerarlo un cambio di prospettiva nel mondo UX/UI? Indubbiamente ci troviamo di fronte all’inizio di un dialogo tra creatività e AI: il flusso di lavoro si accorcia, anche se le competenze richieste si ampliano. Il professionista UX deve ora conoscere i principi che guidano i modelli generativi, ma deve anche essere prompt designer, quindi saper formulare istruzioni efficaci, e riconoscere quando l’automazione semplifica troppo o distorce.

Se lavori nel settore, creare interfacce con l’intelligenza artificiale rappresenta uno sviluppo nell’operatività con cui fare i conti. Comprendere i principi alla base dell’intelligenza artificiale e cos’è il machine learning , significa capire come si stanno ridefinendo i ruoli nel design digitale e quali competenze diventeranno indispensabili.

Dalla progettazione manuale al design generativo

La progettazione digitale è sempre stata un lavoro di osservazione e di sintesi. Il designer interpretava i bisogni dell’utente, traduceva funzioni complesse in percorsi semplici e definiva il linguaggio visivo dell’interfaccia. Ogni elemento – colori, spazi, tipografia – era frutto di scelte deliberate, costruite passo dopo passo.

L’arrivo dell’Intelligenza Artificiale sta introducendo una logica diversa: il codice o il layout vengono generati in tempo reale e così il lavoro del designer sposta il suo focus dalla fase di costruzione a quella di direzione. La creatività, in sostanza, si sposta su un piano più strategico che operativo.

L’evoluzione della UX/UI nell’era dei dati

La progettazione delle interfacce ha sempre seguito il comportamento delle persone. Quando la navigazione sul web era lineare, bastavano pochi percorsi logici e una buona gerarchia visiva. Con la crescita dei dati e dei dispositivi, il design ha dovuto adattarsi a esperienze più fluide, costruite su preferenze e contesti d’uso.

L’UX tradizionale si fondava su test, mappe di calore e cicli di iterazione manuale. Ogni modifica nasceva quindi dall’analisi di ciò che l’utente aveva fatto, non da ciò che avrebbe potuto fare. L’AI ha le capacità per invertire questa direzione grazie ai modelli predittivi, che anticipano bisogni e propongono interfacce dinamiche, che cambiano in base al comportamento.

Naturalmente, questo approccio non cancella i principi di usabilità, ma li estende. La coerenza visiva, l’accessibilità e la semplicità restano centrali, anche se vengono reinterpretate in chiave adattiva. Il risultato è una UX data-informed, dove il valore sta proprio nella capacità di apprendere dai dati per migliorare l’esperienza in tempo reale.

Cos’è Google Stitch e come funziona

Torniamo quindi al tema centrale dell’articolo. Come abbiamo anticipato, Google Stitch è uno strumento sperimentale sviluppato nei laboratori di Google Labs e presentato durante il Google I/O 2025. La sua funzione è trasformare un’idea (espressa in un semplice prompt o attraverso un’immagine) in interfacce digitali complete, pronte per essere esportate o modificate. Stitch utilizza modelli multimodali collegati a Gemini 2.5 Pro, capaci di interpretare testo, immagini e schizzi per generare layout coerenti con le intenzioni descritte dall’utente.

Il principio su cui si basa è chiamato Vibe Coding, per cui la programmazione non nasce più sulla scrittura del codice, bensì dall’uso di prompt o di altri input all’interno di un tool di AI generativa. L’AI riconosce il tono e lo stile impliciti nella descrizione testuale e li traduce in scelte grafiche. In poche parole, scrivendo un prompt come “Genera una dashboard chiara con grafici dinamici e menu laterale minimale”, Stitch produrrà in pochi secondi un’interfaccia interattiva, costruita con componenti pronti per lo sviluppo front-end.

Sebbene possa sembrare un’idea futuristica, questa modalità di programmazione è già concreta e in rapida diffusione, supportata da potenti modelli linguistici come GPT-4 (OpenAI), Code Llama (Meta) e Claude (Anthropic) e dalle numerose piattaforme che li utilizzano. Ma pensiamo anche ad alcuni tool AI per la generazione di video, per esempio Google VEO e Google Flow, e a quelli per lo sviluppo di app come Lovable AI.

Una delle caratteristiche che distingue Stitch è la integrazione diretta con Figma. L’utente può esportare il progetto mantenendo i livelli modificabili o, in alternativa, scaricare il codice sorgente in HTML, CSS o JavaScript. Questo collegamento tra linguaggio naturale, design visivo e codice rende Stitch una piattaforma di prototipazione generativa completa, pensata per ridurre la distanza tra designer e sviluppatore.

Come utilizzare Google Stitch per progettare interfacce

L’utilizzo di Google Stitch è concepito per essere immediato, ma dietro la semplicità dell’interfaccia si nasconde una logica precisa. Il processo parte da un prompt descrittivo, in cui si indica il tipo di schermata, lo stile visivo e gli elementi desiderati. È possibile scrivere frasi in linguaggio naturale oppure caricare un disegno, wireframe o uno screenshot come riferimento visivo.

Il modello AI interpreta il contenuto e genera un layout completo, visualizzabile direttamente nel browser. Da qui, l’utente può intervenire con nuove istruzioni testuali per modificare colori, font, margini o proporzioni. Stitch non richiede conoscenze di codice, ma restituisce sempre output leggibili e pronti all’uso per chi desidera lavorare in HTML, CSS o JavaScript.

La funzione di esportazione verso Figma consente di passare rapidamente alla fase di rifinitura visiva, mantenendo la struttura creata dall’AI. È possibile aggiungere elementi manuali, bloccare componenti o adattarli al sistema di design in uso. Per chi lavora in team, Stitch può diventare un punto di partenza comune, capace di allineare progettisti e sviluppatori sulla stessa base operativa.

Vantaggi dell’uso dell’IA nel design delle interfacce

L’integrazione dell’Intelligenza Artificiale nei processi di progettazione sta modificando l’idea stessa di interfaccia. L’AI permette, sicuramente, di ridurre i tempi di sviluppo, eliminare passaggi ripetitivi e generare varianti in tempo reale, favorendo la sperimentazione visiva.

Uno dei vantaggi più concreti riguarda la velocità decisionale. L’AI analizza pattern, interpreta le scelte cromatiche o tipografiche più coerenti e propone soluzioni compatibili con standard di usabilità consolidati. Questo libera tempo e risorse per la parte strategica del progetto, dove l’attenzione torna al significato dell’esperienza.

C’è poi il tema della collaborazione. In un flusso di lavoro AI-driven, designer e sviluppatori condividono lo stesso linguaggio: il prompt. L’output generato dall’AI può essere migliorato manualmente, ma parte già da una base comune, riducendo incomprensioni e tempi di revisione. Insomma, siamo più vicini al ragionamento iterativo che al disegno sequenziale.

Bisogna poi sottolineare un aspetto che spesso viene sottovalutato. Questo processo di “democratizzazione” dello sviluppo, non elimina comunque la necessità di esperti in programmazione. Sebbene l’AI possa generare interfacce e logiche complete, è il programmatore umano l’unico esperto in grado di garantire che il codice sia sicuro, robusto e manutenibile. La verifica (code review) e il testing (soprattutto in ambito di sicurezza e affidabilità) rimangono responsabilità umane imprescindibili.

Allo stesso, bisogna sottolineare che affidarsi in toto all’AI può portare anche a risultati inaspettati. Il codice generato automaticamente può contenere bug subdoli o falle di sicurezza che richiedono tempo aggiuntivo per l’analisi e il debug da parte di uno sviluppatore esperto. Ecco perché bisogna farne un uso consapevole, trovando un solido equilibrio tra la rapidità di generazione e l’applicazione delle best practice di ingegneria del software.

Come l’IA migliora il processo creativo

Dobbiamo riconoscere un merito a strumenti come Google Stitch. Essi sono in grado di introdurre un approccio iterativo naturale: il designer formula un’idea, osserva il risultato e interviene con nuovi prompt per affinarlo. Il flusso diventa un dialogo continuo tra intuito umano e calcolo algoritmico. Ciò rappresenta un vantaggio non da poco, perché consente di visualizzare in pochi minuti ciò che prima richiedeva ore di disegno, confronto e revisione.

Un secondo effetto riguarda, invece, la fluidità mentale. Quando la parte esecutiva viene delegata, il progettista può concentrarsi su coerenza, tono visivo e significato. Combinazioni cromatiche inattese, spaziature alternative, soluzioni di navigazione sono tutti elementi che stimolano la mente e che aprono nuove strade. Il compito del designer è riconoscere quali di queste opzioni meritano di diventare progetto.

In questo senso, l’AI diventa una forma di pensiero ausiliario, che accelera la ricerca estetica, ma che richiede una guida esperta per non disperdere il senso dell’esperienza utente.

L’evoluzione della progettazione interfacce con AI

L’evoluzione della progettazione guidata dall’Intelligenza Artificiale coinvolge l’intero ciclo di vita dell’interfaccia. Inevitabilmente, questa trasformazione ha ridefinito i confini della figura del designer, che oggi opera come mediatore tra creatività e calcolo. Le decisioni si basano sulla capacità di interpretare gli output dell’AI e di allinearli agli obiettivi di progetto. In un certo senso, la progettazione si sta spostando più verso un approccio data-driven, in cui la qualità nasce dall’interazione costante tra intuizione umana, logica e previsione.

Pensiamo a e-commerce, app mobile e piattaforme SaaS, dove gli strumenti AI-driven consentono di personalizzare layout e contenuti in tempo reale, generando esperienze sempre più rilevanti per l’utente che naviga. Ed ecco che nasce così la Generative UI, in cui design, machine learning e comportamento umano convergono in un unico linguaggio progettuale.

Chi lavora o studia in questo ambito deve sviluppare competenze nuove. Nel Corso di Generative AI di Data Masters approfondiamo proprio questi principi: come utilizzare i modelli generativi per ottimizzare il tuo lavoro, ma anche per realizzare contenuti e sistemi adattivi con un metodo strutturato. L’offerta didattica nel settore AI, però non si limita ai corsi più generici: in catalogo troverai anche il Corso Google Gemini, dedicato all’applicazione pratica dell’AI multimodale nei contesti creativi e aziendali, con applicazioni e casi d’uso concreti.