Il feature engineering rappresenta uno dei pilastri fondamentali nel campo dell’analisi dei dati e del machine learning. Questo processo, spesso sottovalutato ma cruciale, trasforma i dati grezzi in caratteristiche significative che possono determinare il successo o il fallimento di un modello predittivo. In questo articolo approfondiremo tutti gli aspetti dell’ingegneria delle funzionalità, dalle basi teoriche alle applicazioni pratiche, esplorando come questa disciplina stia rivoluzionando il modo in cui gestiamo e interpretiamo i dati.

Cos’è l’ingegneria delle funzionalità

L’ingegneria delle funzionalità, o feature engineering, è il processo attraverso il quale i dati grezzi vengono trasformati in caratteristiche (features) che rappresentano meglio il problema sottostante che si sta cercando di risolvere. Questo processo richiede una profonda comprensione del dominio specifico, creatività e competenze tecniche avanzate. Non si tratta semplicemente di manipolare i dati, ma di creare nuove rappresentazioni che possano catturare meglio le relazioni nascoste all’interno del dataset.

Nel contesto della Data Analysis e del machine learning, il feature engineering diventa fondamentale per migliorare la qualità dei dati di input. Un ingegnere delle funzionalità deve essere in grado di identificare quali caratteristiche sono più rilevanti per il problema in questione e come queste possono essere create o modificate per ottenere risultati migliori.

Le feature, che rappresentano le colonne o gli attributi di un dataset utilizzati per addestrare un modello di machine learning, possono presentarsi in diverse forme. Possiamo trovare caratteristiche numeriche, come l’età o il reddito, caratteristiche categoriche, come il genere o la città di residenza, o caratteristiche più complesse derivate da trasformazioni elaborate dei dati originali. Il processo di feature engineering comprende diverse operazioni sofisticate: dalla creazione di nuove caratteristiche attraverso la combinazione di quelle esistenti, alla trasformazione delle variabili per ottimizzarne la distribuzione; dall’encoding delle variabili categoriche alla gestione accurata dei valori mancanti; dalla normalizzazione e standardizzazione dei dati fino all’estrazione di caratteristiche significative da dati non strutturati. Tutte queste operazioni vengono eseguite con l’obiettivo di creare un set di feature che possa rappresentare al meglio la complessità del problema da risolvere.

Perché è importante il feature engineering

L’importanza del feature engineering nel campo dell’analisi dei dati e del machine learning non può essere sottovalutata. Questa disciplina rappresenta spesso la differenza tra un modello mediocre e uno eccellente. La qualità delle feature utilizzate per addestrare un modello ha un impatto diretto sulle sue prestazioni, e in molti casi, feature ben progettate possono rendere il lavoro dell’algoritmo di apprendimento molto più semplice ed efficace.

Il valore delle feature nei modelli predittivi

I modelli predittivi basano le loro decisioni sulle caratteristiche che vengono loro fornite. Se queste caratteristiche non rappresentano adeguatamente il problema sottostante, il modello non potrà mai raggiungere prestazioni ottimali, indipendentemente dalla sua sofisticatezza. Il feature engineering aiuta a creare una rappresentazione più accurata e informativa del problema, permettendo al modello di identificare pattern e relazioni che altrimenti potrebbero rimanere nascosti.

Per esempio, in un problema di previsione delle vendite, invece di utilizzare semplicemente la data come input, un buon feature engineering potrebbe estrarre informazioni come il giorno della settimana, il mese, la stagione, o se si tratta di un giorno festivo. Queste nuove caratteristiche potrebbero catturare pattern stagionali e cicli di vendita che il modello potrebbe trovare difficile da apprendere dai dati grezzi.

Come il feature engineering migliora le prestazioni del machine learning

Il feature engineering gioca un ruolo cruciale nel miglioramento delle prestazioni dei modelli di machine learning. Questo avviene attraverso diversi meccanismi:

- Semplificazione del problema: Creando feature più informative, il feature engineering può rendere più semplice per il modello apprendere le relazioni nei dati. Invece di dover scoprire pattern complessi da dati grezzi, il modello può lavorare con caratteristiche già significative dal punto di vista del dominio.

- Riduzione della dimensionalità: Attraverso la creazione di feature più significative, è possibile ridurre la dimensionalità dei dati mantenendo o addirittura aumentando il contenuto informativo. Questo può portare a modelli più efficienti e meno soggetti all’overfitting.

- Incorporazione di conoscenza del dominio: Il feature engineering permette di incorporare la conoscenza specifica del dominio nel processo di modellazione. Questo può essere particolarmente importante in campi specializzati come la finanza, la medicina o l’ingegneria.

L’impatto del feature engineering nella riduzione del rumore dei dati

Uno degli aspetti più significativi del feature engineering è la sua capacità di ridurre il rumore nei dati. I dati del mondo reale sono spesso caratterizzati da variazioni casuali che non contengono informazioni utili per il problema da risolvere. Attraverso tecniche mirate di feature engineering, è possibile implementare strategie efficaci per la gestione di queste interferenze, dalla rimozione degli outlier al smoothing dei dati, fino all’aggregazione delle informazioni a livelli più appropriati per l’analisi. Questo processo di raffinamento permette di creare feature più robuste e meno sensibili al rumore, consentendo ai modelli di concentrarsi sugli aspetti veramente rilevanti dei dati. Tale capacità risulta particolarmente preziosa in applicazioni dove il rapporto segnale-rumore è tradizionalmente basso, come nell’analisi di dati finanziari o nelle applicazioni di computer vision.

Differenze tra feature engineering e selezione delle feature

Mentre il feature engineering si concentra sulla creazione e trasformazione delle caratteristiche, la selezione delle feature è un processo complementare ma distinto. La selezione delle feature si occupa di identificare quali caratteristiche sono più rilevanti per il problema in questione, eliminando quelle ridondanti o irrilevanti. Questa distinzione è fondamentale per comprendere il ruolo completo dell’ingegneria delle funzionalità nel processo di machine learning.

Il feature engineering crea nuove caratteristiche attraverso la trasformazione e combinazione di quelle esistenti, mentre la selezione delle feature determina quali di queste caratteristiche (sia originali che ingegnerizzate) sono effettivamente utili per il modello. Entrambi i processi sono cruciali per ottenere prestazioni ottimali, ma operano in modi diversi:

Il feature engineering si concentra sulla creazione di nuove caratteristiche significative, spesso richiedendo una profonda comprensione del dominio specifico. La selezione delle feature, invece, utilizza metodi statistici e algoritmici per valutare l’importanza relativa delle caratteristiche esistenti.

Feature engineering nella data analysis

Nel contesto della Data Analysis, il feature engineering assume un ruolo ancora più ampio. Non si tratta solo di preparare i dati per i modelli di machine learning, ma anche di creare caratteristiche che possano rivelare insight significativi durante l’analisi esplorativa dei dati. Gli analisti utilizzano il feature engineering per:

La comprensione approfondita dei dati richiede spesso la creazione di nuove caratteristiche che possano rivelare pattern nascosti o relazioni non immediatamente evidenti nei dati grezzi. Questo processo iterativo di creazione e analisi delle feature è fondamentale per sviluppare una comprensione completa del dataset e del fenomeno sottostante.

Scopri il nostro percorso di carriera Data Analyst per imparare a padroneggiare le skill dell’analisi dei dati in maniera professionale.

Tecniche comuni per l’ottimizzazione delle variabili

L’ottimizzazione delle variabili nel feature engineering si basa su diverse tecniche specializzate che trasformano i dati per renderli più adatti all’analisi. Due approcci fondamentali sono la gestione delle variabili numeriche e quella delle variabili categoriche.

Per le variabili numeriche, la normalizzazione e la standardizzazione giocano un ruolo cruciale. La normalizzazione ridimensiona i valori in un intervallo specifico, tipicamente tra 0 e 1, mentre la standardizzazione trasforma i dati in modo che abbiano media zero e deviazione standard unitaria. Queste trasformazioni sono essenziali quando si lavora con algoritmi sensibili alla scala dei dati, come il gradient descent o le reti neurali. Per esempio, in un dataset che contiene sia l’età (0-100) che il reddito annuale (0-milioni), senza queste trasformazioni il reddito dominerebbe l’analisi semplicemente per la sua scala maggiore.

L’encoding delle variabili categoriche rappresenta invece il processo di conversione di dati testuali in formato numerico, indispensabile poiché gli algoritmi di machine learning operano esclusivamente su numeri. Per esempio, in un dataset di vendite, una colonna “Stagione” con valori come “Primavera”, “Estate”, “Autunno” e “Inverno” deve essere convertita in formato numerico. Il one-hot encoding crea nuove colonne binarie per ogni categoria, il label encoding assegna un numero a ogni categoria. La scelta tra questi metodi dipende dalla natura dei dati e dal tipo di analisi da effettuare: il one-hot encoding è ideale per categorie senza ordine intrinseco, mentre il label encoding si adatta meglio a categorie ordinali come i livelli di soddisfazione dei clienti.

L’importanza delle feature per scoprire pattern nascosti

Il feature engineering rappresenta uno strumento essenziale per svelare pattern nascosti nei dati, permettendo di identificare relazioni e tendenze che rimarrebbero invisibili nell’analisi dei dati grezzi. Attraverso la creazione di feature appropriate, è possibile trasformare informazioni apparentemente non correlate in insight significativi, rivelando correlazioni complesse e tendenze cicliche che sfuggirebbero a un’analisi superficiale.

Questa capacità di scoprire pattern nascosti si traduce direttamente in valore aziendale, consentendo di identificare indicatori predittivi di tendenze di mercato, pattern comportamentali dei clienti o anomalie significative nei processi operativi. Le feature ben progettate non solo migliorano le prestazioni dei modelli predittivi, ma forniscono anche una base solida per decisioni strategiche basate sui dati, trasformando informazioni complesse in conoscenza actionable.

Tecniche principali di feature engineering

Le tecniche di feature engineering possono essere classificate in diverse categorie, ognuna delle quali serve uno scopo specifico nel processo di preparazione dei dati. Alcune delle tecniche principali includono:

Trasformazioni matematiche: Queste includono operazioni come logaritmi, radici quadrate, potenze e altre trasformazioni che possono aiutare a normalizzare le distribuzioni o linearizzare le relazioni tra variabili. Per esempio, applicare una trasformazione logaritmica a dati fortemente asimmetrici può rendere la distribuzione più normale e più facile da gestire per molti algoritmi.

Creazione di caratteristiche basate sul dominio: Questa tecnica richiede una profonda comprensione del dominio specifico e permette di creare feature che catturano relazioni significative nel contesto del problema. Per esempio, nel campo finanziario, potrebbe includere il calcolo di ratios finanziari o indicatori tecnici.

Aggregazioni temporali: Nel caso di dati temporali, è spesso utile creare feature che catturino trend, stagionalità e altri pattern temporali. Questo può includere medie mobili, calcoli di variazioni percentuali, o aggregazioni su diverse finestre temporali.

Encoding di variabili categoriche: Come detto prima, esistono diverse tecniche per convertire variabili categoriche in formato numerico, tra cui:

- One-hot encoding per categorie nominali

- Label encoding per categorie ordinali

- Target encoding per categorie con alta cardinalità

- Feature hashing per gestire spazi di feature molto grandi

Gestione dei valori mancanti: Le tecniche per gestire i valori mancanti possono includere:

- Imputazione basata sulla media, mediana o moda

- Imputazione basata su modelli predittivi

- Creazione di flag binari per indicare la presenza di valori mancanti

Come si diventa un feature engineer

Il percorso per diventare un feature engineer richiede una combinazione di competenze tecniche, conoscenza del dominio e capacità analitiche. È un ruolo che richiede continuo aggiornamento e apprendimento, data la rapida evoluzione del campo del machine learning e dell’analisi dei dati.

Percorso formativo e competenze richieste

Il percorso per diventare un feature engineer richiede lo sviluppo di un solido background multidisciplinare che combina competenze matematiche, statistiche e tecniche. La base matematica deve includere una profonda comprensione della statistica descrittiva e inferenziale, dell’algebra lineare, della teoria delle probabilità e delle tecniche di ottimizzazione. Queste competenze fondamentali permettono di comprendere e manipolare efficacemente i dati, creando feature significative e statisticamente rilevanti.

Altrettanto importante è lo sviluppo di una profonda comprensione del dominio specifico in cui si opera. Un feature engineer deve padroneggiare i processi aziendali, comprendere i KPI rilevanti e conoscere le sfide specifiche del settore. Questa conoscenza contestuale, unita a solide capacità analitiche, permette di analizzare criticamente i dati, identificare pattern significativi e valutare l’efficacia delle feature create. La capacità di documentare e comunicare le proprie scoperte in modo chiaro e efficace completa il profilo di competenze necessarie per eccellere in questo ruolo.

Linguaggi di programmazione utili: Python, R, SQL

La padronanza dei principali linguaggi di programmazione utilizzati nel campo della data science è fondamentale. I corsi di python sono particolarmente importanti, in quanto Python è diventato lo “standard de facto” nel campo del machine learning e dell’analisi dei dati.

Accanto a Python, R si distingue per le sue capacità statistiche avanzate e la sua specializzazione nell’analisi dei dati, offrendo strumenti potenti per l’analisi esplorativa e la visualizzazione attraverso pacchetti come tidyverse e ggplot2. La sua forte radice statistica lo rende particolarmente adatto per implementare tecniche avanzate di feature engineering basate su metodi statistici.

Un solido background in SQL è altrettanto importante, poiché molti dati aziendali sono archiviati in database relazionali. La capacità di scrivere query SQL efficienti è fondamentale per estrarre e manipolare i dati necessari per il feature engineering.

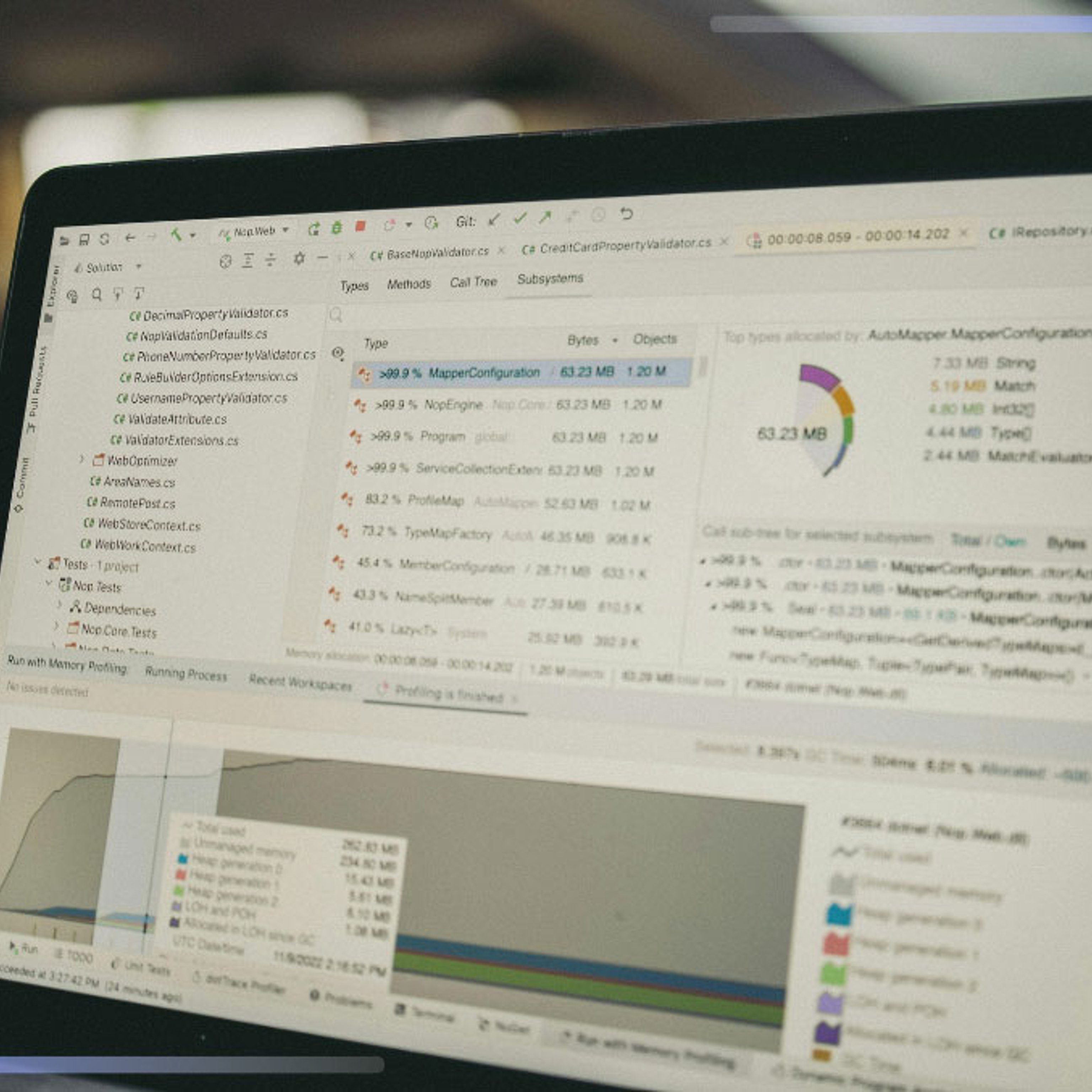

Librerie e strumenti per il feature engineering: Pandas, NumPy, scikit-learn

La padronanza delle principali librerie di data science è essenziale per un feature engineer efficace. Frequentare un corso su Pandas, insieme allo studio approfondito di NumPy e scikit-learn, può costituire un valore aggiunto significativo per chi desidera specializzarsi in questo campo.

Queste librerie rappresentano infatti gli strumenti fondamentali per la manipolazione e l’analisi dei dati in Python. La loro importanza risiede nella complementarietà delle funzioni offerte: mentre Pandas eccelle nella manipolazione e trasformazione dei dati strutturati, NumPy fornisce le fondamenta per calcoli numerici efficienti e scikit-learn offre strumenti avanzati per il machine learning e la feature selection.

Completano il quadro librerie specializzate come Feature-engine e feature-tools per l’automazione del processo, insieme a Matplotlib e Seaborn per la visualizzazione e validazione dei risultati.

Ruolo del feature engineer nel team di data science

Il feature engineer svolge un ruolo cruciale all’interno del team di data science, fungendo da ponte essenziale tra i data engineer e i data scientist. La collaborazione con il team è un aspetto fondamentale del ruolo; il professionista lavora a stretto contatto con i data engineer per garantire l’accesso e la qualità dei dati, con i data scientist per comprendere le esigenze dei modelli e con gli stakeholder aziendali per allineare le feature con gli obiettivi di business.

Le responsabilità quotidiane includono lo sviluppo e la manutenzione di pipeline di feature engineering, il monitoraggio costante della qualità delle feature nel tempo, l’ottimizzazione delle performance e la gestione accurata del versionamento delle feature. Questo insieme di attività richiede non solo competenze tecniche avanzate, ma anche una spiccata capacità di comunicazione e collaborazione con diverse figure professionali, rendendo il ruolo del feature engineer particolarmente dinamico e sfidante all’interno dell’organizzazione.

Certificazioni e corsi per specializzarsi nel feature engineering

Per sviluppare le competenze necessarie, è consigliabile seguire un percorso formativo strutturato. Un corso di data analyst può fornire le basi necessarie, mentre un corso sul machine learning può aiutare a comprendere come le feature influenzano le prestazioni dei modelli.

Le certificazioni più rilevanti includono:

- Certificazioni in Data Science e Machine Learning

- Certificazioni specifiche per strumenti e piattaforme

- Corsi specializzati in feature engineering

- Workshop e bootcamp pratici

Conclusione

Il feature engineering è una disciplina fondamentale nel campo del machine learning e dell’analisi dei dati, che richiede una combinazione unica di competenze tecniche, creatività e comprensione del dominio. La capacità di creare feature efficaci può fare la differenza tra un modello mediocre e uno eccellente, rendendo questa competenza particolarmente preziosa nel mercato del lavoro attuale.

Il percorso per diventare un feature engineer richiede dedizione e continuo aggiornamento, ma le opportunità professionali in questo campo sono numerose e in crescita. Con il giusto mix di formazione teorica, esperienza pratica e comprensione del business, è possibile costruire una carriera gratificante in questo settore in rapida evoluzione.