Negli ultimi mesi c’è una sensazione strana nell’aria, soprattutto se lavori nel digitale, non si tratta della solita ondata di hype, ma qualcosa di più viscerale, quasi fastidioso. Per anni abbiamo sentito parlare di AI come di un futuro lontano. Ora ci ritroviamo ad usarla ogni giorno, spesso senza essere davvero pronti a quello che comporta. Non è fantascienza, è una frizione concreta con il modo in cui lavoriamo, pianifichiamo la carriera, decidiamo cosa imparare.

Il post “Something Big Is Happening” di Matt Shumer ha messo nero su bianco questa sensazione che molti avevano già percepivano ma facevano fatica ad articolare. Qui il focus non è se essere d’accordo su tutto quello che ha scritto Shumer nel suo articolo, quanto il fatto che milioni di persone lo hanno letto e discusso in pochi giorni. Da quel momento, la domanda da un milione di euro non è più se l’AI cambierà il lavoro o no, ma quanto in fretta e quanto profondamente lo farà.

Shumer individua una data precisa, il 5 febbraio 2026, come spartiacque simbolico, il giorno in cui i nuovi modelli hanno reso evidente quello che prima era percepito solo dagli addetti ai lavori. Possiamo discutere se sia davvero la data giusta o meno, ma molti sviluppatori e founder concordano su una cosa: tra il prima e il dopo c’è una differenza che si sente nel lavoro di tutti i giorni.

“Something Big Is Happening”: il post di Matt Shumer e la nuova era dell’AI

Il post di Matt Shumer, “Something Big Is Happening“, ha semplicemente cristallizzato una sensazione che molti di noi, onestamente, covavano da tempo. Il 10 febbraio 2026 in poche ore il suo tweet ha innescato una discussione che ha attraversato ogni angolo della rete professionale. Non si trattava soltanto di un titolo clickbait, ma la descrizione di un punto di non ritorno.

Certo, c’è sempre chi minimizza, chi ricorda che “ne abbiamo già viste tante”. Ma stavolta potrebbe essere un po’ diverso. Il 2026 non è un anno come gli altri, è l’anno in cui l’AI, da strumento di supporto o curioso esperimento, ha piantato le tende nel cuore operativo di ogni professione che abbia a che fare con uno schermo.

Oltre l’hype: il parallelo con i grandi momenti di rottura tecnologica

Guardiamo in retrospettiva ai momenti che hanno ridefinito interi settori. L’arrivo di Internet, l’avvento del personal computer, persino l’introduzione della catena di montaggio. Ogni volta c’è stato un coro di scettici, di chi pensava che si trattasse solo di una moda passeggera o di un giocattolo per pochi. Come chi pensava che i cavalli sarebbero stati sempre migliori delle auto, e invece…

Con l’AI attuale la sensazione è diversa per un motivo semplice: non tocca solo gli strumenti che usiamo, tocca la parte più “mentale” del lavoro, quella che molti consideravano difficilmente automatizzabile. Non stiamo sostituendo un software con un altro, stiamo mettendo in mezzo un sistema che scrive codice, analizza documenti, genera strategie, propone design e aiuta a prendere decisioni. Questo spiega perché la reazione emotiva è così forte: entusiasmo, curiosità, ma anche difesa, cinismo, perfino rifiuto.

Cosa è successo davvero il 5 febbraio 2026: l’impatto di GPT-5.3 e Claude 4.6

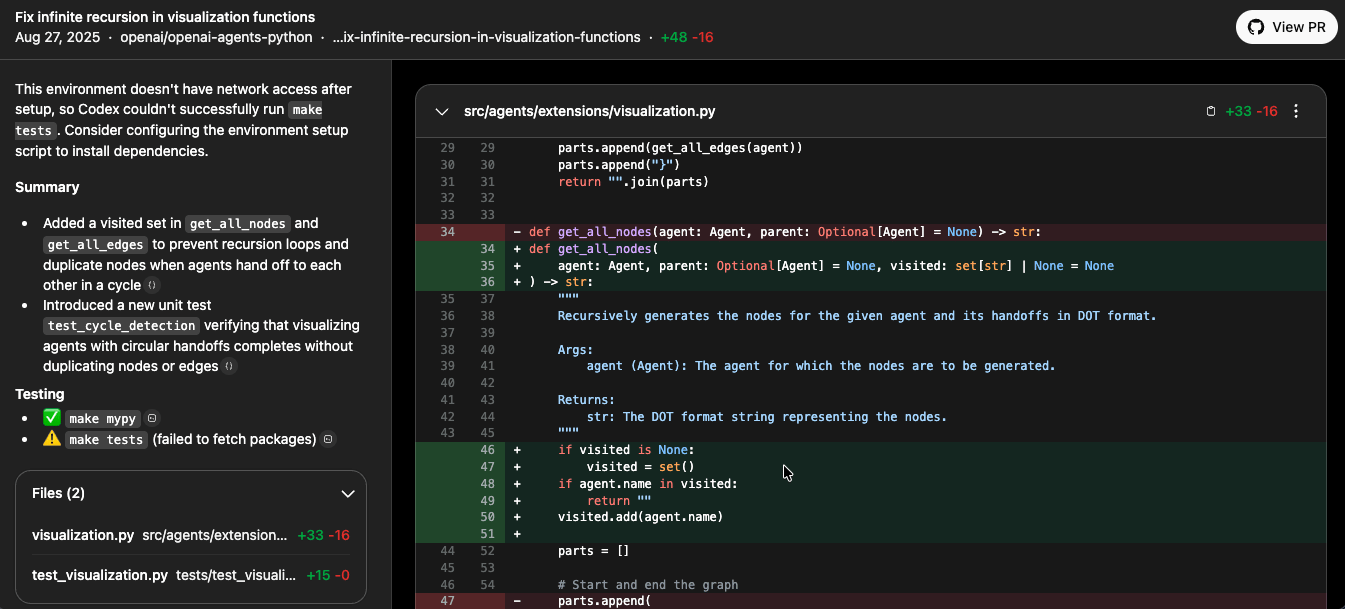

Il 5 febbraio 2026 non è stata solo un’altra release. Con GPT‑5.3‑Codex e Claude Opus 4.6, la sensazione diffusa fra chi li usa davvero non è “un po’ meglio della versione precedente”, ma “ok, forse qualcosa sta cambiando davvero”.

Su GPT‑5.3‑Codex, i commenti dei developer sono abbastanza chiari. Per molti è il primo modello che regge davvero carichi di lavoro da generalista del coding e non solo completamenti di codice bello da vedere, ma con poca sostanza nella pratica quotidiana.

fonte: https://chatgpt.com/s/cd_68af322cda408191a3502e63817b4062

Allo stesso tempo, non è magia. Appena alzi l’asticella e gli fai toccare codebase grossi, il modello tende ancora a “vedere” solo una parte del sistema, faticando a cogliere davvero il disegno complessivo se non gli prepari il contesto in modo intelligente.

Per Claude Opus 4.6 il racconto è simile ma con un accento diverso. La comunità lo percepisce come fortissimo sul ragionamento profondo, sulla sicurezza e sul codice legacy, è il modello di cui si racconta che abbia trovato centinaia di vulnerabilità in software vecchio di decenni che i tool tradizionali non avevano mai visto.

Autonomia e capacità end-to-end: come i nuovi modelli riscrivono il software

La vera novità è la capacità di questi modelli di gestire interi cicli di lavoro, in modo autonomo ed end-to-end. Per la prima volta, un’AI può prendere una specifica di alto livello, scomporla in piccole task, generare il codice necessario, testarlo, identificare i bug e correggerli. Tutto da sola.

Questa non è automazione di task singoli, è automazione di processi cognitivi complessi. La programmazione, così come l’abbiamo conosciuta, è stata la prima a sentire l’onda d’urto, perché è un dominio altamente logico e formalizzato, perfetto per essere dissezionato e ricostruito da un’intelligenza artificiale con capacità di astrazione così avanzate.

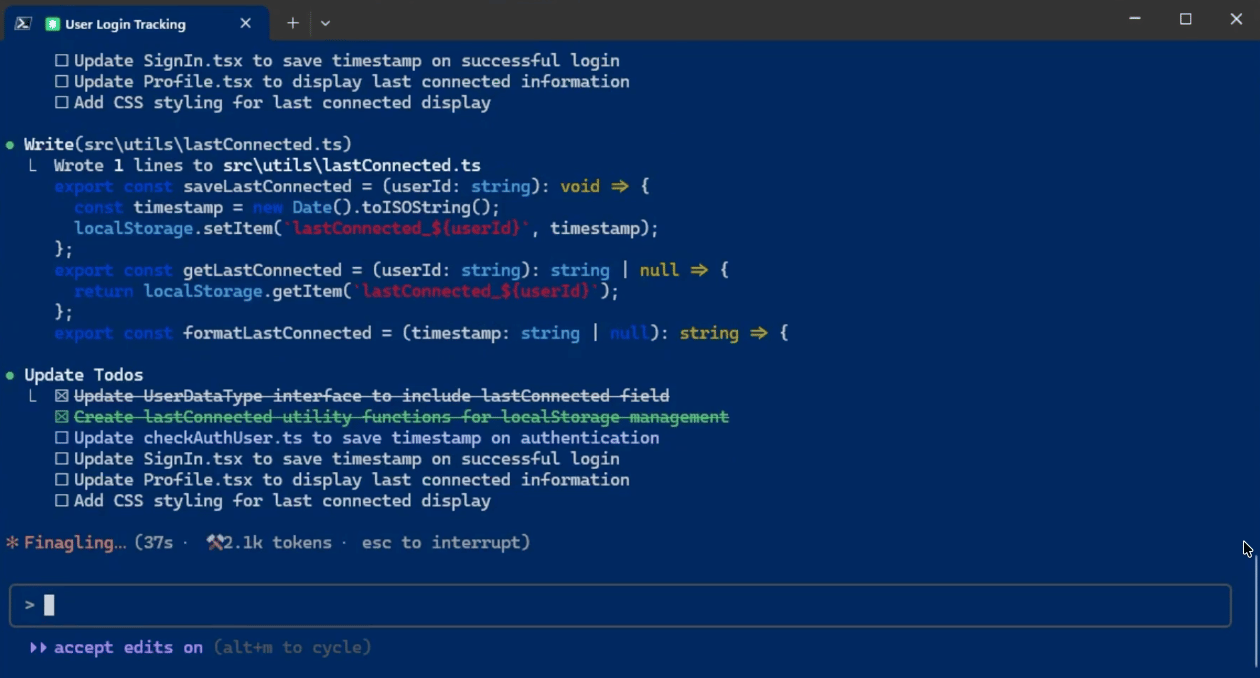

Nella pratica, in tanti team la giornata assomiglia sempre di più a questo flusso di lavoro:

- descrivi una feature in modo decente, con requisiti e vincoli;

- lasci che l’AI generi la prima versione di API, modelli, test, documentazione;

- poi passi una buona fetta del tempo a leggere, rifinire, buttare, rilanciare dove non è all’altezza, decidendo cosa può entrare davvero in produzione.

È un lavoro molto meno da tastiera e molto più di editing e regia, se vogliamo declinarla in termini meno tecnici. Non è l’AI che si prende il lavoro dall’oggi al domani, è l’AI che rende improvvisamente negoziabile quella parte di attività che pensavamo intoccabile perché troppo specialistica, ripetitiva ma ingenuamente ritenuta “nostra”.

L’AI può davvero sostituire i developer?

La domanda è inevitabile, e onestamente, se guardiamo alle capacità di GPT-5.3 Codex di generare app complete da una descrizione in linguaggio naturale, o a quelle di Claude Opus 4.6 di analizzare e riscrivere sezioni intere di codice legacy, la risposta non è più un semplice “no”.

Il lavoro quotidiano è cambiato radicalmente. Molti sviluppatori senior, quelli che hanno visto passare tante mode, sono i primi ad ammetterlo. Non si sta più a scrivere ogni singola riga di codice, spesso, guidiamo l’AI che lo fa. Si finisce a definire l’architettura ad alto livello, a convalidare gli output, a risolvere i problemi più complessi e concettuali che l’AI, per ora, non è in grado di affrontare.

fonte: datamasters corso “AI per sviluppatori”

Non è la fine dei developer, ma la fine dello sviluppo “manuale”

Secondo noi il rischio più sottovalutato è pensare che “tanto l’AI non pensa come me, quindi chissene…“. È vero, ma non è più necessario che lo faccia per eseguire un’enorme fetta del lavoro di programmazione. Non è la fine dei developer, intendiamoci, ma è senza dubbio la fine dello sviluppo manuale come pratica dominante.

Il confronto non è più tra chi scrive il codice più elegante a mano, ma tra chi impara a orchestrare sistemi di agenti e modelli e chi continua a fare tutto da solo. Il vero valore si sposta qui, nella conoscenza approfondita dei progetti e del dominio in cui si lavora.

Serve una profonda comprensione dei principi di informatica, software engineer, della sicurezza, della scalabilità. Ma, soprattutto, serve la capacità di comunicare efficacemente con l’AI (cosa non così scontata per noi sviluppatori), di “promptare” in modo strategico, di validare i suoi risultati con occhio critico. È un lavoro più concettuale, più da architetto e meno da operaio della tastiera.

Se il tuo lavoro vive su uno schermo, sei dentro: l’impatto sui lavori cognitivi

Se pensi che questo riguardi solo i programmatori, probabilmente stai guardando solo una parte del quadro. Se il tuo lavoro oggi si svolge quasi tutto davanti ad uno schermo, ricerchi informazioni, analizzi dati, produci report, documenti, contenuti, strategie, è difficile pensare che l’AI non lo toccherà.

In molti studi legali, agenzie, team finance o marketing le persone raccontano già giornate in cui metà del lavoro è chiedere ad un modello di fare la prima bozza, e l’altra metà è sistemare, verificare, decidere cosa tenere e cosa scartare. Non è un banale “non c’è più il lavoro”, è più sottile: sparisce il tempo pagato per fare lavori meccanici che un modello può sbrigare in minuti, e viene premiata la capacità di usare questi strumenti per consegnare più valore nello stesso tempo.

In alcuni studi legali e società di consulenza che hanno iniziato ad usare seriamente questi modelli, i tempi di analisi di documenti, due diligence e reportistica si riducono in modo drastico, spesso dell’ordine di decine di punti percentuali, anche se i numeri precisi variano da caso a caso. Questo non significa che l’avvocato o il consulente spariranno come figure professionali, ma che una persona che non sa usare l’AI rischia di diventare rapidamente troppo lenta e troppo costosa per un’azienda, rispetto a chi la integra bene nel proprio flusso.

Il feedback loop: l’intelligenza artificiale che migliora sé stessa

La cosa che più spaventa ed affascina allo stesso tempo è il concetto di feedback loop. L’AI non solo impara dall’uomo, ma impara da sé stessa.

In pratica, una parte del lavoro che prima richiedeva mesi di lavoro manuale si comprime in settimane, perché i modelli sono dentro il loop di sviluppo, non solo all’uscita. È qui che le famose “scaling laws” (e.g. l’idea che aumentando regolarmente dati e potenza di calcolo, le prestazioni crescono secondo schemi abbastanza prevedibili), incontrano la realtà quotidiana di chi sviluppa questi sistemi.

Alcuni vedono in questo una premessa per una possibile “intelligence explosion”, dove ogni generazione di modelli accelera la successiva. Altri fanno notare che ci sono ancora vincoli molto concreti: costi di calcolo, dati di qualità, regolazione, problemi di sicurezza.

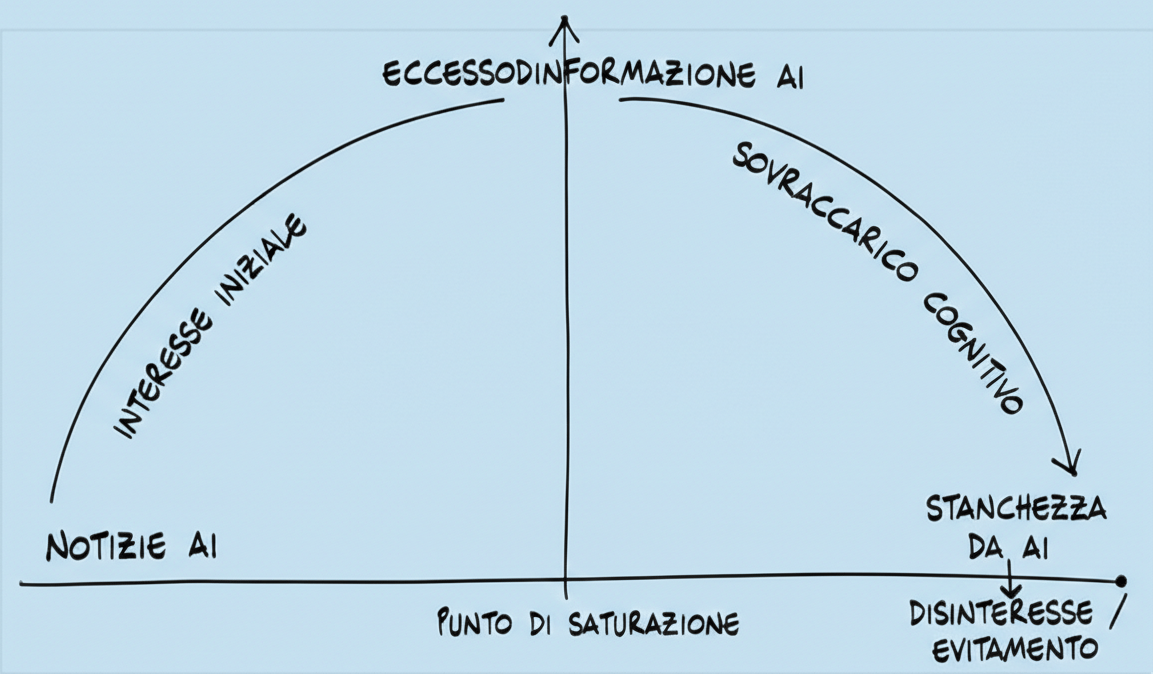

AI Fatigue: perché molti stanno sottovalutando la portata del cambiamento

Perché, nonostante tutto questo, molti sembrano ancora sottovalutare il cambiamento che sta accadendo? C’è un fenomeno che ultimamente si sta facendo spazio nelle conversazioni relative agli strumenti AI, la cosidetta “AI Fatigue“.

Fonte: datamasters (ispirata al grafico di Charlot Erca di Makkox)

Siamo stati bombardati per mesi ed anni da un’ondata di informazioni, spesso contraddittorie, sull’AI, ogni giorno un nuovo tool ed un nuovo annuncio. Questa saturazione informativa ha portato ad una sorta di indifferenza, una resistenza psicologica al nuovo che, alla fine, sembrava sempre una versione appena migliore di ciò che c’era già. È facile cadere nella trappola delle esperienze passate, credendo che anche questo ennesimo salto sia solo un incremento marginale. Ma non lo è.

La differenza critica tra i modelli Free Tier e i modelli Frontier

La verità è che la maggior parte delle persone ha interagito con le versioni free o modelli di fascia consumer. GPT-5.2 o modelli simili, per quanto impressionanti, non sono minimamente paragonabili alle capacità di GPT-5.3 Codex o Claude Opus 4.6. La differenza è abissale, quasi come confrontare un motorino con un jet da combattimento.

I modelli frontier, quelli su cui si basano le vere rivoluzioni attuali, sono accessibili principalmente a grandi aziende, team di ricerca specifici o a pagamento con costi a volte non indifferenti. Non aver sperimentato direttamente queste capacità di punta, porta ad una percezione distorta e a una sottovalutazione pericolosa del potenziale reale.

Hype, ansia e interessi in gioco

C’è poi un altro pezzo di onestà da mettere sul tavolo. La narrativa dell’ansia e dell’urgency fa comodo alle aziende che vivono di AI.

Non vuol dire che il problema non esista, vuol dire che dobbiamo imparare a tenere insieme due verità scomode: da una parte sottovalutare questi cambiamenti è pericoloso, perché alcune fasi del lavoro stanno diventando oggettivamente automatizzabili molto più in fretta del previsto, dall’altra, lasciarsi guidare solo dall’ansia è il modo migliore per fare scelte affrettate, comprare qualsiasi cosa prometta “AI” sulla scatola e poi ritrovarsi con poco di concreto in mano.

Un tono autentico, oggi, dovrebbe riconoscere entrambe le cose, c’è chi spinge il pedale del panico per vendere, ma c’è anche chi usa questi modelli tutti i giorni e si rende conto che, al netto dell’hype, il loro impatto è reale e crescente.

La vera biforcazione: usare l’AI o competere contro di essa

Guardando a come si stanno muovendo aziende e professionisti, si intravede una biforcazione meno spettacolare ma molto concreta. Non è più “AI vs umani”, ma chi usa l’AI in modo superficiale, come un tool occasionale per risparmiare qualche minuto e chi costruisce intorno all’AI sistemi, processi, prodotti, e la propria professionalità.

Le due categorie del futuro: User occasionali vs AI Developer

Chi è allora l’AI Developer? Non è più solo chi scrive algoritmi di machine learning. È colui che comprende a fondo le capacità e i limiti dei modelli più avanzati. È chi sa progettare architetture che integrano più AI, chi sa orchestare flussi di lavoro complessi dove l’AI prende decisioni autonome, e chi ha la sensibilità critica per validare gli output, garantire l’affidabilità e gestire i bias.

Il suo kit di strumenti non è fatto solo di linguaggi di programmazione, ma di strategie di prompt engineering, di tecniche di integrazione API avanzate e di una solida comprensione etica e funzionale. È un ruolo che richiede una mentalità olistica e proattiva.

Cosa fare nei prossimi 12 mesi: una roadmap pratica per non restare indietro

Allora che si fa? La risposta è semplice e brutale: sperimenta ogni giorno. Inizia con piccoli progetti, anche personali. Prova a far generare codice a GPT-5.3, anche per un task banale. Usa Claude Opus 4.6 per analizzare e riassumere documenti complessi, poi controlla l’accuratezza. Costruisci un portfolio di questi mini-progetti in cui l’AI è il tuo collaboratore principale. Non basta leggere articoli o guardare video, devi sporcarti le mani. È l’unico modo per sviluppare quella sensibilità che ti permetterà di capire veramente cosa puoi fare con questi modelli.

Come diventare un AI Developer: il percorso di Data Masters

Noi di Data Masters è ovvio che abbiamo una prospettiva “di parte”. Proprio per questo, cerchiamo di essere i più trasparenti possibili. Vediamo, parliamo e lavoriamo ogni giorno con persone che passano da un uso sporadico di ChatGPT o Claude a progetti in cui l’AI è davvero al centro del flusso di lavoro, e la differenza di opportunità sul mercato del lavoro è reale.

Il nostro Percorso AI Developer nasce esattamente da qui, non dall’idea che senza questo corso sei spacciato, ma dalla constatazione che chi costruisce un portfolio di progetti seri, misurati e documentati, entra nelle conversazioni giuste con aziende e clienti. YouTube e i tutorial che si possono trovare gratis online sono ottimi per farsi un’idea delle basi, ma difficilmente ti portano, da soli, ad affrontare progetti end‑to‑end di casi reali e professionali con una misurazione delle proprie competenze durante la fase di studio.

Un percorso strutturato e project‑based ha esattamente questo obiettivo: aiutarti a passare dal “so usare i modelli” al “so costruire sistemi con i modelli”. Se vuoi trasformare questa fase di incertezza in un’opportunità concreta, la chiave non è consumare contenuti giusto per sfamare quella FOMO da AI, ma produrre più risultati che parlino al posto tuo.