Nel lavoro quotidiano con i Large Language Models la differenza tra un risultato utile e uno inutilizzabile sta spesso in come formuliamo la richiesta. Il JSON prompting è una tecnica per definire in modo strutturato cosa vogliamo dall’AI e in quale formato, così da ottenere risposte più coerenti, prevedibili e facili da integrare nei processi aziendali.

Invece di una richiesta generica, si fornisce al modello uno “schema” preciso dell’output atteso (campi, tipi di dato, vincoli), spesso in formato JSON. In questo modo l’LLM riduce le divagazioni e produce output più adatti a essere usati in automatismi, API e pipeline di dati.

Cos’è il JSON prompting e come funziona

Il JSON prompting consiste nel chiedere al modello di generare un output che rispetti una certa struttura JSON: chiavi specifiche, tipi di valore attesi, eventuali elenchi di opzioni ammesse. In alcuni casi anche il prompt stesso viene organizzato in JSON (con sezioni come context, task, constraints, output_schema), ma il punto centrale è che il modello sappia esattamente come deve essere organizzata la risposta.

Questo approccio chiarisce cosa è obbligatorio, cosa è opzionale, quali formati sono accettati e quali no, rendendo la risposta più semplice da validare e da utilizzare in modo automatico.

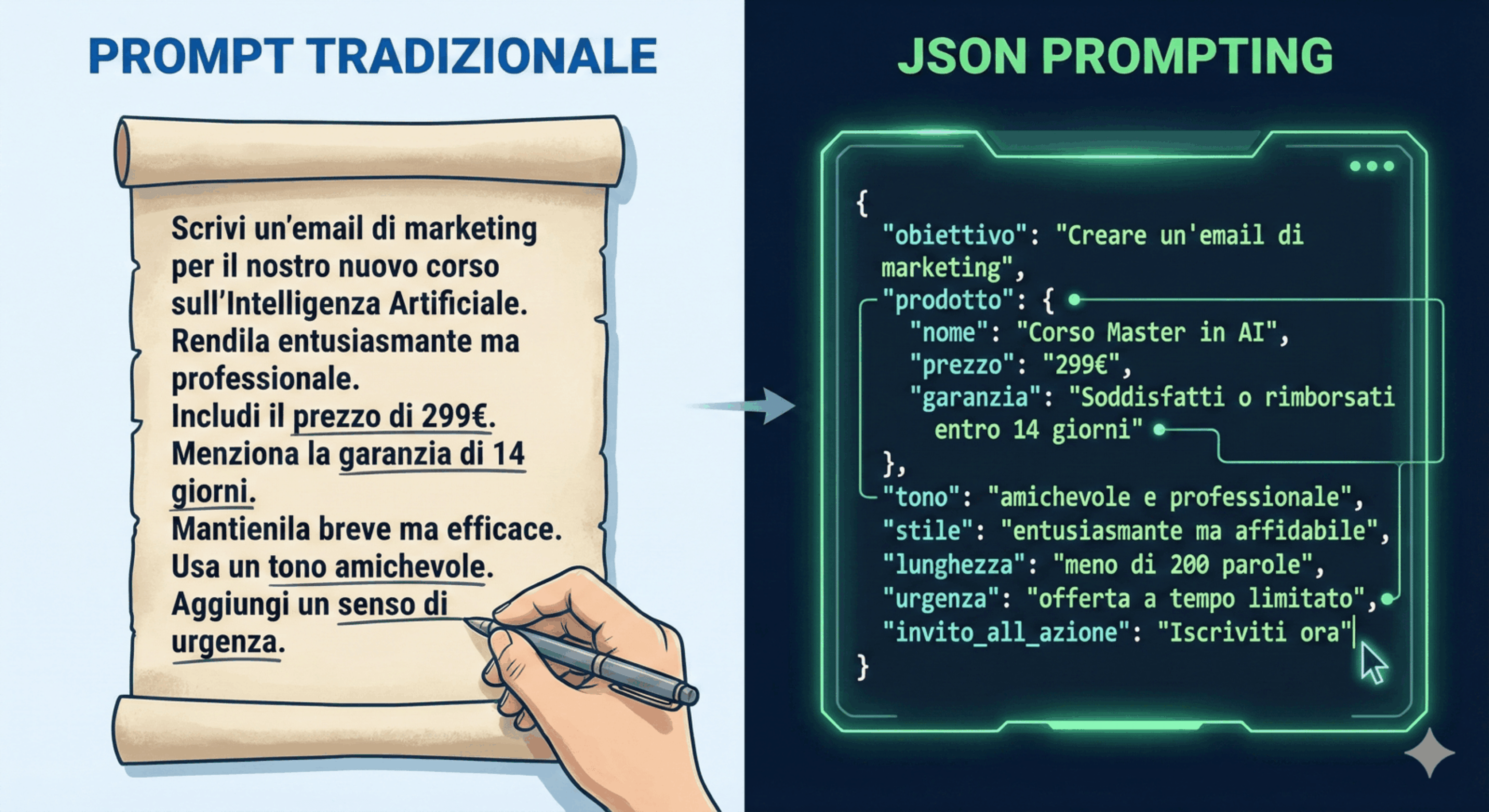

Prompt Testuale

Scrivi un’email di marketing per il nostro nuovo corso sull’Intelligenza Artificiale. Rendila entusiasmante ma professionale. Includi il prezzo di 299€. Menziona la garanzia di 14 giorni. Mantienila breve ma efficace. Usa un tono amichevole. Aggiungi un senso di urgenza.

JSON Prompt

{ "obiettivo": "Creare un'email di marketing", "prodotto": { "nome": "Corso Master in AI", "prezzo": "299€", "garanzia": "Soddisfatti o rimborsati entro 14 giorni" }, "tono": "amichevole e professionale", "stile": "entusiasmante ma affidabile", "lunghezza": "meno di 200 parole", "urgenza": "offerta a tempo limitato", "invito_all_azione": "Iscriviti ora" }

L’importanza dell’ingegneria del contesto nel JSON prompting

Se il JSON prompting definisce cosa vogliamo che l’AI ci dia, l’ingegneria del contesto (context engineering) si occupa di ciò che l’AI sa quando le facciamo quella richiesta. È un po’ come dare un briefing completo prima di una riunione importante. Non basta dire “parlami del progetto X“, ma è fondamentale fornire tutto il background necessario: chi sono gli stakeholder, quali sono gli obiettivi, quali i problemi pregressi e quali i dati rilevanti.

Nel mondo degli LLM, il contesto è il pane quotidiano del modello. Un prompt JSON, per quanto ben strutturato, non può operare nel vuoto, dobbiamo assicurarci che il modello abbia accesso a tutte le informazioni pertinenti per generare una risposta accurata ed informata. Questo può significare includere dati rilevanti direttamente nel prompt JSON, oppure integrare il modello con sistemi esterni di recupero delle informazioni, come quelli che permettono di implementare un sistema RAG da zero.

L’obiettivo è minimizzare l’ambiguità e massimizzare la rilevanza, guidando l’AI non solo sul formato, ma anche sulla sostanza. Senza un contesto adeguato, anche il prompt JSON più impeccabile potrebbe restituire un’insalata di dati tecnicamente corretta ma praticamente inutile. È la differenza tra avere una ricetta perfetta e avere anche tutti gli ingredienti a disposizione.

Come utilizzare il JSON prompting in modo efficace

Utilizzare il JSON prompting non significa semplicemente avvolgere una domanda in graffe e virgolette. Richiede una certa arte e, diciamocelo, un po’ di ingegneria. Il primo passo è la chiarezza: prima di scrivere una singola riga di JSON, dobbiamo avere un’idea cristallina di quale output desideriamo. Quali sono i campi essenziali? Quali le relazioni tra essi? Che tipo di dati devono contenere? Pensare in termini di schema è fondamentale.

Successivamente, è cruciale essere specifici con le istruzioni. Non limitatevi a definire i campi, aggiungete vincoli ed esempi. Se un campo deve contenere una data, specificate il formato (YYYY-MM-DD). Se un valore deve essere scelto da un elenco predefinito, elencate quelle opzioni. Un esempio ben strutturato nel prompt può valere più di mille parole, guidando il modello con un faro luminoso. È inoltre buona pratica iniziare con prompt JSON semplici e aumentarne la complessità man mano, testando e iterando per affinare la precisione. Ricordate, l’AI è un apprendista volenteroso, ma ha bisogno di istruzioni chiare e dirette. Per approfondire queste tecniche, un Corso AI Prompt Engineering può fare miracoli.

Strumenti e tecniche per migliorare l’efficienza del JSON prompting

Per massimizzare l’efficienza del JSON prompting, possiamo avvalerci di alcune tecniche e, in un certo senso, di “strumenti” che rendono il processo più fluido. Uno di questi è l’uso di “schemi JSON” veri e propri. Definire uno schema JSON per il vostro output desiderato non solo offre una validazione automatica (se il modello sgarra, lo sapete subito), ma serve anche come una documentazione chiara di ciò che il vostro sistema si aspetta. Esistono librerie e piattaforme che permettono di generare schemi e validare gli output, rendendo il lavoro più robusto.

Un’altra tecnica efficace è l’integrazione di agenti AI programmati per analizzare la risposta dell’LLM, verificarne la conformità allo schema JSON desiderato e, se necessario, ritentare il prompt con istruzioni più specifiche o un contesto aggiuntivo. Questo crea un ciclo di feedback che migliora la qualità dell’output nel tempo.

Per chi vuole spingersi oltre in questo campo, l’AI Agentic Applications Masterclass offre spunti preziosi per costruire sistemi AI più sofisticati e autonomi. L’idea è di non lasciare l’AI a briglia sciolta, ma di darle un sistema di guida e controllo per assicurarsi che i suoi sforzi siano sempre allineati ai nostri obiettivi.

I benefici del JSON prompting in azienda

L’adozione del JSON prompting in ambito aziendale non è una moda passeggera, ma una vera e propria strategia per ottimizzare l’interazione con l’Intelligenza Artificiale. Il primo, e forse più evidente, vantaggio è la consistenza dell’output. Immaginate di dover estrarre informazioni strutturate da centinaia di documenti o di generare descrizioni prodotto uniformi per un e-commerce. Con il prompting tradizionale, l’AI potrebbe variare la formattazione, i campi o persino il tono. Con il JSON prompting, l’output sarà sempre conforme allo schema desiderato, facilitando l’automazione e l’integrazione con altri sistemi aziendali.

Questo porta direttamente al secondo beneficio: efficienza ed automazione. Un output strutturato è un output facile da parsare e da elaborare automaticamente. Non c’è bisogno di scrivere codice complesso per “pulire” o “normalizzare” la risposta dell’AI, perché è già pulita all’origine. Questo accelera processi come l’analisi dei dati, la generazione di contenuti, la creazione di report e l’interazione con i database, trasformando task manuali e ripetitivi in flussi di lavoro fluidi e automatizzati. Meno tempo speso a sistemare i dati, più tempo per analizzarli e agire.

Infine, il JSON prompting migliora drasticamente l’affidabilità e la riducibilità. Se l’AI sa esattamente cosa produrre e in che formato, le probabilità di errori diminuiscono drasticamente. Questo è cruciale in ambienti aziendali dove decisioni importanti dipendono dall’accuratezza dei dati generati dall’AI. Inoltre, la natura strutturata del JSON rende i prompt più facili da debuggare e da mantenere. Se qualcosa va storto, è più semplice identificare se il problema risiede nel prompt, nel contesto o nel modello stesso. È un passo avanti per rendere l’AI non solo intelligente, ma anche incredibilmente pratica e affidabile, trasformandola in un vero alleato strategico.

Quando il JSON prompting è un over-kill

Il JSON prompting non rende il modello “più intelligente”: migliora soprattutto il formato e la struttura dell’output, non le conoscenze o il ragionamento dell’LLM. Se il modello non ha informazioni corrette, produrrà comunque una risposta ben formattata ma sbagliata.

Specialmente per compiti fortemente creativi o di ragionamento, imporre da subito una struttura JSON molto rigida può introdurre attrito: spesso conviene lasciare il modello ragionare in linguaggio naturale e solo alla fine chiedere di trasformare il risultato in JSON.

In scenari puramente conversazionali o di uso “umano” (es. brainstorming personale, email isolate, chat esplorative), il JSON prompting aggiunge complessità senza portare un reale vantaggio: è più utile quando l’output deve essere consumato da software o inserito in workflow ripetibili.

I consigli di Data Masters su come utilizzare il JSON prompting in azienda

Per trarre il massimo dal JSON prompting, noi di Data Masters abbiamo qualche consiglio pratico, frutto della nostra esperienza nel mondo del Machine Learning e dell’AI.

Pensate allo schema, non solo alla domanda

Prima di digitare, visualizzate l’output ideale come un documento JSON. Quali chiavi, quali valori, quali nidificazioni? Questa mentalità strutturata è la chiave per un prompting efficace.

Fare tanti test

Non aspettatevi la perfezione al primo colpo, l’interazione con gli LLM è un processo iterativo. Iniziate con un prompt JSON semplice, valutate la risposta, poi affinate il prompt aggiungendo complessità, vincoli e dettagli, fino a ottenere il risultato desiderato. Non abbiate paura di sperimentare.

Non sottovalutate il contesto.

Come abbiamo visto, il context engineering è fondamentale. Assicuratevi che il modello abbia tutte le informazioni necessarie per generare una risposta accurata. Se necessario, integrate il JSON prompting con tecniche avanzate di recupero delle informazioni. Per approfondire l’argomento e capire come queste tecniche si inseriscono in un percorso più ampio, potreste dare un’occhiata al nostro percorso di carriera AI Developer.

Investite nella formazione

L’AI è uno strumento potente, ma solo se si sa come usarlo. Formare i vostri team sulle tecniche di prompt engineering, JSON prompting e sull’integrazione di questi strumenti nei flussi di lavoro aziendali è un investimento che ripaga.

Non solo si migliora la qualità e l’efficienza del lavoro con l’AI, ma si dota il personale delle competenze necessarie per innovare e guidare la trasformazione digitale. In Data Masters, offriamo formazione teorica e pratica per aziende sulle AI, perché crediamo fermamente che la conoscenza sia il vero motore del progresso. Non a caso, in una chiacchierata interessante, abbiamo discusso della necessità di essere un “maestro artigiano” delle AI, e il JSON prompting è sicuramente uno degli strumenti migliori nella cassetta degli attrezzi di un artigiano moderno.

Il JSON prompting non è solo un modo per parlare agli LLM, ma un metodo per dettare le regole del gioco, trasformando la loro incredibile versatilità in una risorsa strutturata e prevedibile per la vostra azienda. E nell’era dei dati, avere il controllo sulla struttura e sulla qualità dell’informazione è, senza mezzi termini, un superpotere.