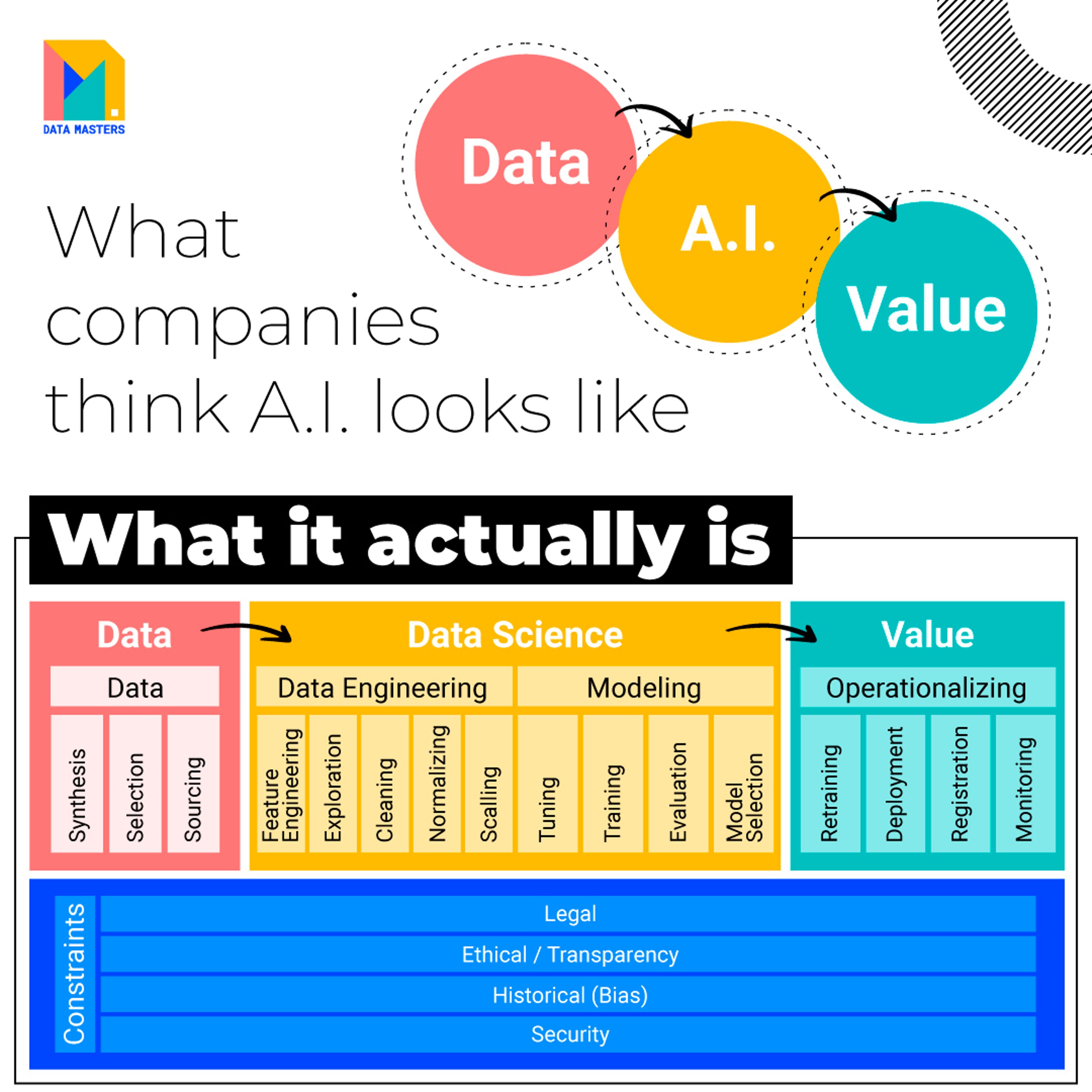

L’Intelligenza Artificiale sta rivoluzionando il mondo del business, ma molte aziende faticano ancora a comprendere il vero potenziale. Spesso, l’AI viene vista come una “black box” che trasforma semplicemente i dati in valore.

Tuttavia, il processo di generazione del valore informativo attraverso i dati è ben più complesso e coinvolge numerosi passaggi ed operazioni strategiche.

Dal dato grezzo al valore informativo

Per ottenere risultati significativi è essenziale seguire un processo ben strutturato che coinvolga diverse fasi e operazioni. A partire dalla raccolta e pre-elaborazione dei dati, passando per la Data Engineering fino alla gestione dei bias e agli aspetti legali, etici, sociali e di sicurezza, ogni passaggio richiede competenze specifiche e una visione olistica. Queste attività coinvolgono figure specializzate e professionisti di Data Science, Machine Learning e AI, che collaborano per ottenere output di valore.

Vediamo nel dettaglio!

Raccolta e pre-elaborazione dei dati: la raccolta di dati accurati e rappresentativi è fondamentale per garantire risultati affidabili. Ciò include operazioni come la sintesi, la selezione e la ricerca, oltre alla trasformazione e all’integrazione dei dati provenienti da diverse fonti. È necessario eseguire anche una pre-elaborazione dei dati che include operazioni come la rimozione di duplicati, la gestione dei valori mancanti e l’eliminazione di anomalie per ridurre il rumore e migliorare la qualità dei dati. Queste attività sono fondamentali per garantire che l’AI possa estrarre informazioni utili dai dati grezzi.

Data Engineering: la data engineering è responsabile della progettazione e della gestione delle infrastrutture per gestire e processare il flusso dei dati. Questo processo include la creazione di schemi di database, l’implementazione di pipeline di elaborazione dei dati e lo sviluppo di sistemi di storage scalabili ed efficienti.

Feature Engineering: la feature engineering è il processo di selezione e trasformazione delle variabili di input (features) dei dati per migliorarne la rappresentazione e facilitare l’apprendimento da parte dei modelli di Machine Learning. Questo processo può includere la normalizzazione, la riduzione della dimensionalità e la creazione di nuove features derivanti da quelle esistenti.

Data Exploration: l’esplorazione dei dati prevede l’analisi e la visualizzazione delle variabili per comprendere caratteristiche, relazioni tra di esse, individuare pattern e anomalie e generare ipotesi da testare con i modelli. Questa fase può includere la visualizzazione dei dati, l’analisi delle correlazioni e la verifica della distribuzione delle variabili.

Data Cleaning: il data cleaning è un passaggio cruciale per correggere o eliminare errori, valori mancanti, inconsistenze e inesattezze nei dati. Questo processo migliora la qualità dei dati e riduce il rumore che potrebbe compromettere i risultati dell’analisi, garantendo che i dati siano affidabili e utili nel processo decisionale.

Data Normalization e Scaling: la normalizzazione e lo scaling dei dati sono tecniche utilizzate per ridimensionare le variabili di input, in modo che abbiano un intervallo comune e siano confrontabili tra loro. Assicurando che tutte le variabili siano su una scala simile, si evita che le differenze di scala influenzino negativamente l’apprendimento del modello e la comparabilità dei risultati. Questo passaggio migliora la convergenza e la stabilità dei modelli durante il training.

Model Selection e Training: la selezione del modello prevede la scelta dell’algoritmo di Machine Learning più adatto al problema in esame. Il training consiste nell’allenare l’algoritmo su un set di dati di addestramento, in modo che possa apprendere le relazioni tra le variabili e fare previsioni su dati non visti.

Hyperparameter Tuning: il tuning degli iperparametri riguarda l’ottimizzazione dei parametri di un algoritmo di Machine Learning per migliorarne le prestazioni e ridurre l’errore di generalizzazione. Questo processo può essere effettuato attraverso diverse tecniche, come la ricerca su griglia, la ricerca casuale e l’ottimizzazione bayesiana.

Model Evaluation: prevede la valutazione delle prestazioni del modello addestrato su un set di dati di test, utilizzando metriche come l’accuratezza, la precisione, il recall e l’F1 score. Questa fase permette di determinare se il modello è accurato, generalizzabile e adatto alle esigenze dell’organizzazione.

Deployment e Monitoring: dopo aver scelto il modello più adatto, è necessario implementarlo nell’ambiente di produzione e integrarlo con le applicazioni e i servizi aziendali. Il deployment richiede una gestione attenta delle risorse, come la scalabilità, la latenza e la resilienza del sistema. Inoltre, è fondamentale monitorare continuamente le performance del modello in produzione per identificare eventuali problemi, degradazioni delle prestazioni o cambiamenti nelle distribuzioni dei dati. Il monitoring consente di mantenere l’accuratezza del modello nel tempo e di eseguire aggiornamenti o correzioni in modo proattivo.

Responsabilità e sicurezza nell’era dell’AI

Oltre ai processi tecnici, è cruciale considerare gli aspetti potenzialmente critici o sensibili nell’implementazione e nell’utilizzo dell’Intelligenza Artificiale come le implicazioni legali, la Responsible AI, la gestione dei bias e la sicurezza.

Le implicazioni legali dell’utilizzo dell’AI riguardano principalmente la protezione dei dati, la privacy e la conformità normativa. Le aziende devono assicurarsi di rispettare le leggi e regolamentazioni locali e internazionali per evitare sanzioni e danni alla reputazione.

La Responsible AI si riferisce all’adozione di pratiche etiche e sostenibili nell’uso dell’Intelligenza Artificiale. Questo concetto prevede la considerazione dell’impatto sociale e ambientale delle soluzioni basate sull’AI, la promozione della trasparenza e l’accountability delle decisioni prese dai modelli di AI, nonché l’attenzione alla diversità e all’inclusione nel processo di sviluppo.

Un ulteriore elemento chiave riguarda la gestione dei bias nei dati o nei modelli di AI, che possono portare a risultati discriminatori o ingiusti. È essenziale identificare e mitigare questi bias attraverso tecniche come il bias auditing, il re-sampling e l’implementazione di algoritmi di apprendimento equi. In questo modo si garantisce che l’AI sia imparziale e non perpetui disuguaglianze esistenti.

Infine, la sicurezza dei dati e dei modelli di AI è cruciale per proteggere la privacy degli utenti e prevenire attacchi informatici. Le aziende devono implementare misure di sicurezza adeguate, come la crittografia, l’autenticazione a più fattori e il monitoraggio delle minacce, per garantire che i dati sensibili e i modelli di AI siano protetti e sicuri.

Investire nella formazione e nella cultura interna

Le aziende che non si aggiornano e non creano una cultura interna focalizzata sull’intelligenza artificiale spesso tendono a percepire questa tecnologia come una black box. Per massimizzare il valore dell’AI, è fondamentale investire nella formazione e nello sviluppo delle competenze del team, in modo che tutti i membri dell’organizzazione comprendano i processi e le strategie coinvolte nell’implementazione e nell’utilizzo dell’AI.

Creare valore nel business attraverso l’AI e i dati richiede un approccio olistico e multidisciplinare che va oltre il semplice sviluppo e l’implementazione dei modelli. Integrare corsi di intelligenza artificiale nella formazione aziendale permette di affrontare anche gli aspetti legali, etici, sociali e di sicurezza, rafforzando la cultura interna. Solo così, le aziende potranno sbloccare l’intero potenziale informativo dei dati, trasformandoli in un asset strategico per offrire soluzioni innovative e garantirsi così un vantaggio competitivo duraturo.