Negli ultimi mesi il tema dell’alfabetizzazione sull’intelligenza artificiale è entrato con forza nel dibattito pubblico e aziendale. Non si tratta di una moda né di una nuova etichetta per indicare competenze digitali generiche. Con l’entrata in vigore dell’AI Act, l’AI literacy diventa un elemento strutturale nel modo in cui le imprese adottano, governano e controllano l’uso dei sistemi di intelligenza artificiale.

Oggi l’intelligenza artificiale incide su processi decisionali, gestione dei lavoratori, selezione del personale, analisi dei dati e interazione con clienti e cittadini. In questo contesto, non comprendere come funzionano questi sistemi, quali rischi introducono e quali responsabilità generano espone le aziende a criticità operative, legali e reputazionali. Per questo l’alfabetizzazione in materia di intelligenza artificiale non riguarda più il singolo individuo, ma l’organizzazione nel suo insieme.

L’AI Act chiarisce inoltre un concetto chiave: usare l’IA non è solo una scelta tecnologica, ma una decisione di governance che richiede competenze adeguate, supervisione umana e consapevolezza normativa. Comprendere cosa significhi davvero AI literacy, su chi ricade questo obbligo e perché è diventato centrale per le imprese è il primo passo per affrontare il nuovo scenario senza improvvisazioni, ed è proprio da qui che conviene iniziare ad analizzare cosa cambia concretamente per le aziende.

AI Act: cosa cambia per le aziende che usano l’intelligenza artificiale

L’entrata in vigore dell’AI Act segna un cambio di prospettiva netto per le aziende che utilizzano sistemi di intelligenza artificiale. L’IA non viene più considerata solo una tecnologia abilitante, ma un insieme di strumenti che incidono direttamente su diritti, sicurezza e processi decisionali. Per questo motivo viene introdotto un modello di regolazione europeo che sposta l’attenzione dal risultato tecnico alla responsabilità dell’organizzazione che adotta l’IA.

Il cuore dell’AI Act è l’approccio basato sul rischio. Non tutti i sistemi di intelligenza artificiale vengono trattati allo stesso modo: ciò che conta è come e dove vengono utilizzati. Quando l’IA entra in ambiti sensibili come la gestione dei lavoratori, la selezione del personale, l’accesso ai servizi o il trattamento dei dati, le aziende devono dimostrare di aver valutato l’impatto di queste tecnologie e di aver predisposto misure adeguate di controllo e supervisione.

In questo scenario, l’alfabetizzazione sull’intelligenza artificiale assume un ruolo centrale. Comprendere il funzionamento dei sistemi, i loro limiti e i rischi associati diventa una condizione necessaria per prendere decisioni consapevoli. L’AI Act non chiede alle imprese di essere esperte di algoritmi, ma di essere in grado di governare l’uso dell’IA all’interno dei propri processi, ed è qui che la AI literacy smette di essere un concetto teorico per trasformarsi in un requisito operativo.

Quali obblighi introduce l’AI Act per le imprese

Con l’AI Act, le imprese non sono chiamate semplicemente a “usare meglio” l’intelligenza artificiale, ma a dimostrare di aver costruito un sistema di controllo e consapevolezza adeguato. Gli obblighi introdotti dal regolamento non riguardano solo gli aspetti tecnici dei sistemi, ma soprattutto le competenze delle persone che li progettano, li gestiscono e li utilizzano nei processi aziendali.

Il principio di fondo è chiaro: non può esistere un uso responsabile dell’IA senza un’adeguata preparazione di chi la governa. Per questo l’AI Act collega in modo diretto la conformità normativa alla capacità dell’organizzazione di comprendere i rischi, valutare gli impatti e intervenire quando necessario. In questo quadro, la formazione non è un adempimento accessorio, ma una parte integrante della compliance.

È qui che il tema dell’alfabetizzazione sull’intelligenza artificiale assume una valenza concreta. L’obiettivo non è creare competenze tecniche avanzate in ogni ruolo, ma garantire che chi prende decisioni sull’uso dell’IA sia in grado di farlo con cognizione di causa, conoscendo limiti, responsabilità e conseguenze operative delle scelte adottate.

Obbligo di formazione sull’intelligenza artificiale

Dal 2 febbraio 2025 l’AI literacy diventa un obbligo esplicito per le organizzazioni che forniscono o utilizzano sistemi di intelligenza artificiale. L’alfabetizzazione in materia di intelligenza artificiale ricade sui fornitori e sui deployer, cioè su tutte le aziende che integrano l’IA nei propri processi, indipendentemente dal fatto che i sistemi siano sviluppati internamente o acquisiti da terzi.

La normativa chiarisce che la formazione deve essere adeguata al contesto di utilizzo. Questo significa che non esiste un percorso unico valido per tutti: il livello di alfabetizzazione richiesto dipende dal ruolo delle persone coinvolte, dal tipo di sistema adottato e dal rischio associato al suo impiego. Chi supervisiona l’uso dell’IA, ad esempio, deve possedere competenze diverse rispetto a chi interagisce con il sistema in modo operativo.

Un altro aspetto centrale riguarda la documentazione della formazione. Le imprese devono poter dimostrare di aver formato il personale in modo coerente e continuativo, mantenendo traccia delle attività svolte. In questo modo l’alfabetizzazione sull’intelligenza artificiale diventa uno strumento concreto di governo del rischio, strettamente legato alla supervisione umana e alla capacità dell’organizzazione di intervenire in modo consapevole quando emergono criticità.

Requisiti di compliance per l’uso dell’AI in azienda

Accanto all’obbligo di formazione, l’AI Act introduce una serie di requisiti di compliance che le imprese devono integrare nei propri processi decisionali. L’uso dell’intelligenza artificiale non può più essere affidato a iniziative isolate o a singoli reparti: richiede una governance strutturata, capace di coordinare competenze, responsabilità e controlli lungo tutto il ciclo di vita dei sistemi.

In questo contesto diventano centrali le valutazioni d’impatto. Per i sistemi che trattano dati personali o presentano profili di rischio elevati, le aziende devono affiancare alla DPIA prevista dal GDPR la FRIA introdotta dall’AI Act, valutando non solo la protezione dei dati, ma anche l’impatto sui diritti fondamentali, come la non discriminazione o l’accesso equo al lavoro. Considerarle separatamente riduce la loro efficacia; leggerle come parti di un unico processo decisionale rafforza la capacità dell’organizzazione di prevenire criticità reali.

Un ulteriore elemento di compliance riguarda l’integrazione dell’uso dell’IA nei sistemi di controllo interno. Per molte imprese questo significa aggiornare il Modello Organizzativo 231, mappando i nuovi rischi tecnologici e definendo procedure chiare di supervisione. In questo quadro, l’alfabetizzazione sull’intelligenza artificiale svolge una funzione abilitante: senza competenze diffuse e consapevoli, anche i migliori modelli di governance restano sulla carta, mentre la compliance diventa un esercizio formale anziché uno strumento di governo effettivo.

Rischi e responsabilità per le aziende che utilizzano l’AI

Quando un’azienda introduce sistemi di intelligenza artificiale nei propri processi, i rischi non riguardano solo il corretto funzionamento della tecnologia. Il punto centrale è come queste soluzioni influenzano decisioni, persone e diritti, soprattutto nei contesti in cui l’IA supporta o automatizza scelte che hanno effetti concreti su lavoratori, clienti e cittadini.

Uno dei rischi più sottovalutati è quello legato ai bias algoritmici. Sistemi addestrati su dati incompleti o distorti possono produrre risultati discriminatori, anche in assenza di un’intenzione esplicita. A questo si aggiungono i problemi di opacità decisionale, che rendono difficile comprendere perché un sistema abbia generato una determinata decisione, e il rischio di affidarsi eccessivamente all’automazione, riducendo il ruolo della supervisione umana.

In questo quadro, la responsabilità dell’azienda non deriva dall’uso dell’intelligenza artificiale in sé, ma dalla mancanza di governo dei processi che la coinvolgono. Senza competenze adeguate, valutazioni d’impatto e controlli interni, l’IA può amplificare errori organizzativi già presenti. È per questo che l’alfabetizzazione sull’intelligenza artificiale diventa una leva di prevenzione: aiuta le imprese a riconoscere i rischi prima che si trasformino in problemi operativi o legali, preparando il terreno per comprendere anche le conseguenze in caso di mancato adeguamento.

Sanzioni per le aziende in caso di mancato adeguamento

Il sistema sanzionatorio previsto dall’AI Act rappresenta l’ultimo livello di tutela del quadro normativo, ma non è il suo obiettivo principale. Le sanzioni intervengono quando l’azienda non ha costruito processi adeguati di governo dell’intelligenza artificiale, ignorando obblighi di valutazione, formazione e supervisione. In questi casi, le conseguenze possono essere rilevanti, sia sul piano economico sia su quello reputazionale.

La vigilanza sull’applicazione della normativa è affidata, in Italia, a soggetti istituzionali come AgID e ACN, che hanno il compito di monitorare l’uso dei sistemi di IA, effettuare ispezioni e applicare le misure previste in caso di violazioni. Le sanzioni possono arrivare fino a 35 milioni di euro o al 7% del fatturato globale annuo, a seconda della gravità e della natura dell’inadempienza.

È importante però leggere questo aspetto nel modo corretto. Il rischio maggiore non è la sanzione in sé, ma l’assenza di una struttura organizzativa capace di prevenire gli errori. Le aziende che investono in alfabetizzazione sull’intelligenza artificiale, governance e valutazioni d’impatto riducono drasticamente l’esposizione a questi scenari, trasformando la conformità normativa in un elemento di stabilità e continuità operativa.

AI Act e imprese: i consigli di Data Masters per mettersi in regola

Affrontare il tema dell’AI literacy in azienda richiede un cambio di approccio. Non basta reagire agli obblighi normativi con interventi isolati o corsi una tantum. Serve una visione che tenga insieme formazione, governance e strategia, adattandole al contesto reale in cui l’intelligenza artificiale viene utilizzata.

Il primo passo consiste nel mappare i casi d’uso dell’IA presenti in azienda e valutarne il livello di rischio, alla luce dell’AI Act. Da qui diventa possibile definire percorsi di alfabetizzazione sull’intelligenza artificiale coerenti con i ruoli coinvolti, rafforzando la supervisione umana e la capacità decisionale. Per comprendere il quadro normativo di riferimento e le implicazioni pratiche, può essere utile approfondire le novità per chi lavora con l’intelligenza artificiale e i cambiamenti dell’AI Act per imprese e cittadini.

Un secondo elemento chiave riguarda l’integrazione dell’AI literacy nei processi di compliance. Collegare formazione, DPIA, FRIA e sistemi di controllo interno permette di ridurre il rischio di interventi correttivi tardivi, rendendo l’adozione dell’IA più solida nel tempo. In questa prospettiva, comprendere perché le aziende devono comprendere l’AI Act diventa parte integrante di una strategia di innovazione responsabile.

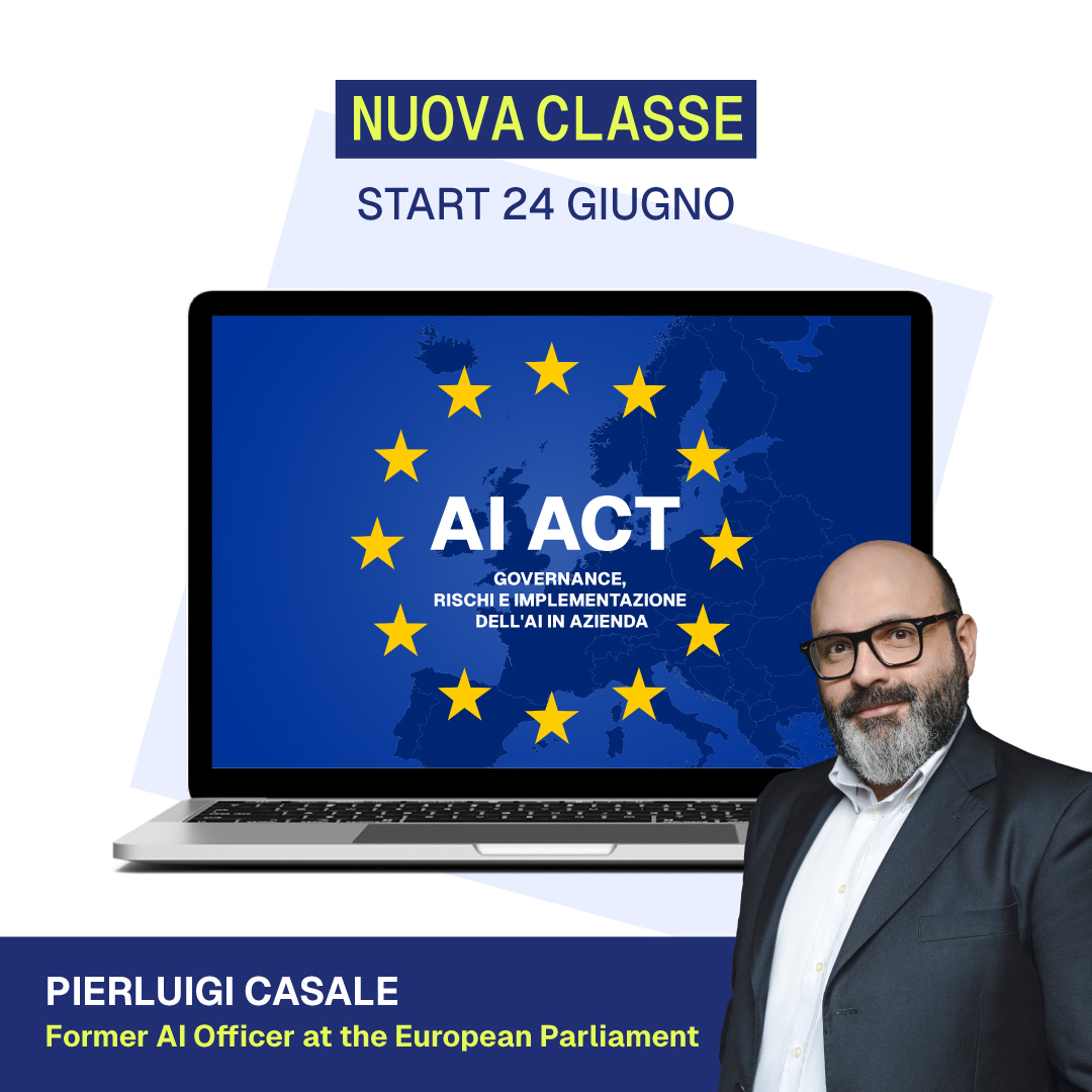

Infine, l’alfabetizzazione sull’intelligenza artificiale può trasformarsi in un vero vantaggio competitivo quando viene inserita in un percorso strutturato di crescita delle competenze. Investire nella formazione per aziende sull’intelligenza artificiale significa preparare le persone a usare l’IA in modo consapevole, sostenibile e allineato agli obiettivi di business. È su questa integrazione tra regole, competenze e visione che si gioca la differenza tra un’adozione difensiva dell’IA e una capacità reale di innovare nel lungo periodo, anche attraverso percorsi come il Corso all’AI in Azienda.