Quando OpenAI annunciò per la prima volta Sora AI, si scatenò un putiferio non solo tra i cineasti e i creatori di contenuti, ma in tutto l’ecosistema dell’AI generativa. La promessa di video che sfidano la nostra percezione della realtà, mantenendo una coerenza stilistica e fisica su durate significative, ha fatto sorgere domande tanto ovvie quanto cruciali. Sora è davvero la rivoluzione che ci era stata promessa? Come si colloca ora, a distanza di mesi dal suo rilascio, rispetto ai colossi e alle svariate alternative che popolano il mercato?

Cos’è Sora AI

Per cogliere l’essenza di Sora AI, dobbiamo guardare oltre l’etichetta di “generatore di video da testo”. Sviluppato da OpenAI, Sora è un modello di intelligenza artificiale che ha segnato un punto di non ritorno nella creazione di contenuti video.

Il cuore pulsante di Sora è un modello di diffusione, una tecnologia che ha già dimostrato la sua potenza nella generazione di immagini, ma qui applicata al dominio del tempo e del movimento. È stato addestrato su un dataset vastissimo e variegato di video e descrizioni testuali, che gli ha permesso di imparare non solo “come appaiono le cose”, ma anche “come si muovono ed interagiscono nel mondo”. A differenza dei suoi predecessori, che spesso si arenavano nella creazione di brevi clip o animazioni stilizzate piene di artefatti, Sora è in grado di produrre video di durata significativa (fino a 20 secondi nei piani più avanzati), mantenendo una qualità visiva, una coerenza temporale e una fedeltà al prompt notevoli. Questo si traduce in personaggi che non cambiano volto da un fotogramma all’altro, oggetti che rispettano le leggi della gravità e una narrazione visiva che fluisce in modo logico, senza i “glitch” che tradivano l’origine artificiale dei primi esperimenti.

La vera marcia in più di Sora non sta solo nella sua capacità di assemblare pixel in movimento, ma nella sua profonda comprensione del mondo fisico. OpenAI ha sottolineato come Sora abbia sviluppato una comprensione implicita delle dinamiche del mondo reale: le relazioni spaziali, le proprietà dei materiali, la causa e l’effetto. Questo gli consente di simulare scene complesse con una fedeltà sorprendente, anche quando gli elementi richiesti nel prompt sono bizzarri o mai visti prima.

Le sue funzionalità principali, oggi accessibili attraverso diverse modalità, includono:

- Generazione da testo a video (Text-to-Video): L’utente fornisce una descrizione testuale e Sora la traduce in un video, interpretando personaggi, azioni, ambienti, stili artistici e persino il mood della scena.

- Estensione di video esistenti: Una delle capacità più interessanti è quella di prendere un video esistente e di estenderlo, generando nuovi fotogrammi che precedono o seguono la clip originale, mantenendone intatti stile e contenuto.

- Generazione da immagine a video (Image-to-Video): Partendo da un’immagine statica, Sora può animarla, infondendole vita e movimento in modo coerente con il contesto dell’immagine stessa.

- Inpainting e outpainting video: Similmente a quanto avviene per le immagini, Sora può modificare, rimuovere o aggiungere elementi all’interno di un video, oppure espandere l’inquadratura generando ciò che si troverebbe al di fuori dei bordi originali.

- Flessibilità stilistica: Il modello può essere indirizzato a generare video in un’ampia gamma di stili, dal fotorealismo più spinto all’animazione, dal bianco e nero d’epoca all’estetica cyberpunk, offrendo una versatilità creativa notevole.

Quanto costa Sora

L’accesso a Sora si articola principalmente su due canali: la piattaforma ufficiale di OpenAI e l’integrazione con i servizi Microsoft.

Per chi cerca l’esperienza più completa, la via maestra è la piattaforma di OpenAI. Qui, Sora è accessibile tramite due principali piani a pagamento:

- ChatGPT Plus: Con un costo di circa 20 dollari al mese, questo piano rappresenta la porta d’ingresso all’ecosistema premium di OpenAI. Offre la possibilità di generare video con Sora, ma con alcune limitazioni: la durata massima è di solito contenuta entro i 10 secondi, la risoluzione si ferma a 720p e i video prodotti presentano un watermark. È la scelta ideale per chi vuole sperimentare lo strumento senza un impegno economico eccessivo.

- ChatGPT Pro: Rivolto a un’utenza professionale e con un prezzo decisamente più impegnativo di circa 200 dollari al mese, questo piano sblocca il pieno potenziale di Sora. Permette di generare video più lunghi (fino a 20 secondi), in alta risoluzione (1080p), senza watermark e con la possibilità di avviare fino a cinque generazioni simultaneamente, riducendo i tempi di attesa.

L’alternativa gratuita: Bing Video Creator

La notizia più interessante per molti è che sì, è possibile usare Sora gratuitamente. Microsoft, partner strategico di OpenAI, ha integrato una versione di Sora nel suo Bing Video Creator. Questo servizio, accessibile tramite il sito di Bing, l’app mobile o il browser Edge, permette a chiunque di testare la tecnologia di Sora senza alcun abbonamento.

Naturalmente, la gratuità ha un prezzo in termini di funzionalità. La versione integrata in Bing è limitata: i video generati sono molto brevi (solitamente tra i 5 e i 10 secondi), la risoluzione è più bassa (variabile tra 480p e 720p), i tempi di elaborazione possono essere lunghi a causa delle code e i file sono soggetti a una moderazione più stringente. È un ottimo modo per farsi un’idea delle capacità del modello, ma non è una soluzione pensata per un uso professionale.

Per fare chiarezza, ecco una tabella riassuntiva dei piani disponibili:

| Piano | Prezzo | Durata max video | Risoluzione | Caratteristiche Principali |

| ChatGPT Plus | ~20$/mese | Fino a 10 secondi | 720p | Presenza di watermark, tempi di attesa variabili |

| ChatGPT Pro | ~200$/mese | Fino a 20 secondi | 1080p | Nessun watermark, 5 generazioni simultanee, priorità in coda |

| Bing Video Creator | Gratuito* | 5-10 secondi | 480p-720p | Coda di elaborazione, limiti di utilizzo, moderazione dei contenuti |

*Disponibile in diverse regioni, soggetto a test e limiti di utilizzo variabili.

Sora è il migliore strumento AI di generazione video?

La domanda se Sora sia “il migliore” è diventata più complessa da quando non è più solo una demo impressionante ma un prodotto sul mercato. La risposta, come sempre nel mondo della tecnologia, è un sonoro “dipende”. Dipende dal caso d’uso, dal budget e dalle priorità creative. Sora ha indubbiamente definito un nuovo standard di qualità, ma la concorrenza non è rimasta a guardare, e il campo di battaglia della generazione video AI è più affollato e agguerrito che mai.

Sora vs. Midjourney

Il confronto con Midjourney è l’emblema della specializzazione. Midjourney è, e rimane, il sovrano indiscusso della generazione di immagini statiche. La sua capacità di produrre composizioni artisticamente impeccabili, con un controllo stilistico e una resa estetica che spesso lasciano a bocca aperta, lo rende il preferito di artisti e designer. Sora si occupa di movimento e narrazione temporale. Mentre Midjourney cristallizza un singolo istante perfetto, Sora lo estende in una sequenza. È vero che anche Midjourney sta iniziando a introdurre funzionalità video, ma il suo DNA rimane quello di un maestro dell’immagine fissa. Non sono tanto rivali diretti quanto due artisti eccelsi in discipline diverse: uno è un fotografo, l’altro un regista.

Sora vs. Google VEO

Questa è la vera “battaglia dei titani”. Google VEO è la risposta diretta di Mountain View a Sora. Annunciato con promesse simili, VEO punta a generare video di alta qualità e di lunga durata, con un’enfasi particolare sul controllo cinematografico, come movimenti di camera complessi (droni, carrellate, etc.) e sulla coerenza narrativa. La sfida qui si gioca su un terreno simile: qualità, realismo e comprensione del prompt. C’è da dire che la grandissima differenza sta nel fatto che con VEO si possono generare dei video con l’audio mentre con Sora questa opzione non è ancora disponibile. Questa caratteristica pone sicuramente in una posizione di vantaggio Google rispetto ad Open AI.

Sora vs. Runway

Il confronto con Runway è forse il più pragmatico. Runway non è un nuovo arrivato, è una piattaforma consolidata e apprezzata che offre una suite completa di strumenti video basati sull’AI. Non si limita alla generazione da testo, ma fornisce un arsenale di funzionalità per l’editing: rimozione di sfondi, cancellazione di oggetti, stilizzazione di video esistenti (video-to-video), e molto altro. Il suo punto di forza è la versatilità. Runway è un coltellino svizzero per il videomaker moderno. Sora, al confronto, è più simile a un bisturi di precisione, focalizzato sulla generazione di altissima qualità da zero. La competizione si sta facendo più serrata, con le nuove versioni di Runway, come Gen-3, che puntano a migliorare notevolmente la consistenza dei personaggi e la qualità generale, avvicinandosi al territorio di Sora.

La scelta, quindi, si riduce alle necessità:

- Se cercate la massima qualità fotorealistica per una generazione di un video da zero e siete disposti a pagare per essa, Sora e Veo sono probabilmente il punto di riferimento attuale.

- Se avete bisogno di una suite di editing video AI completa e versatile, che includa anche buone capacità generative, Runway è una scelta solida e matura.

- Se l’obiettivo è creare immagini statiche artisticamente sbalorditive, Midjourney resta ineguagliato, anche se ultimamente sta prendendo sempre più piede Nano Banana di Google.

È fondamentale ricordare che questo è un campo in evoluzione rapidissima. I benchmark di oggi potrebbero essere obsoleti domani. L’invito è a sperimentare e a consultare test e recensioni aggiornate per capire quale strumento si adatti meglio al proprio flusso di lavoro.

Come utilizzare Sora: guida passo dopo passo

Che stiate usando la versione completa su ChatGPT Pro o quella più limitata su Bing Video Creator, i principi fondamentali non cambiano. L’ingrediente segreto rimane uno: la qualità del vostro prompt.

Fase 1: L’accesso allo strumento

- Scegliere la piattaforma: Decidete se volete l’esperienza completa a pagamento tramite OpenAI o l’assaggio gratuito tramite Bing Video Creator.

- Aprire l’interfaccia: Su OpenAI, troverete l’opzione per Sora all’interno dell’ambiente ChatGPT. Su Bing, cercate “Video Creator”. Entrambi vi presenteranno un campo di testo per il prompt ed un pulsante per generare.

Fase 2: L’arte e la scienza del Prompt Engineering

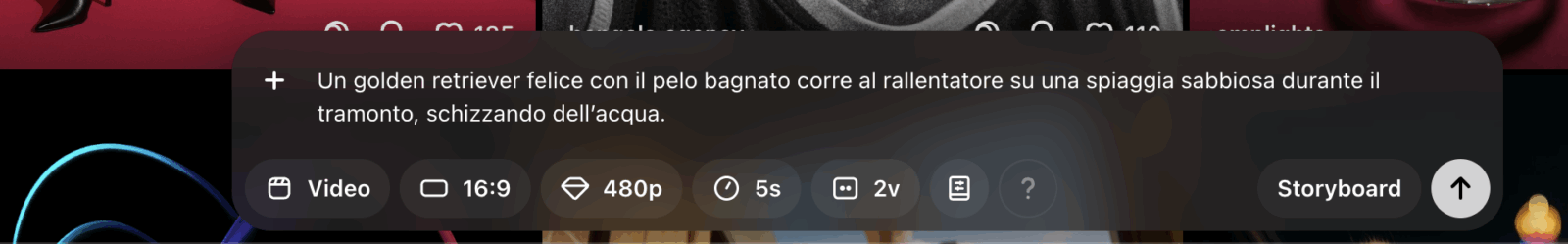

Il prompt è il vostro copione, la vostra sceneggiatura e le vostre istruzioni di regia. Più sarete precisi, più Sora si avvicinerà alla vostra visione.

- Siate descrittivi e specifici: Non limitatevi a “un cane che corre”. Provate con “Un golden retriever felice con il pelo bagnato corre al rallentatore su una spiaggia sabbiosa durante il tramonto, schizzando dell’acqua.”

- Soggetto: Chi o cosa è il protagonista.

- Azione: Cosa sta facendo.

- Ambiente: Dove si svolge la scena. Includete dettagli sull’illuminazione, il meteo, l’ora del giorno.

- Stile visivo: Specificate lo stile. “Video cinematografico in 8K”, “filmato d’archivio in bianco e nero”, “animazione in stile Ghibli”, “video da drone iperrealistico”.

- Composizione e inquadratura: Descrivete i movimenti di camera. “Inquadratura dal basso”, “lenta carrellata laterale”, “ripresa aerea che segue un’auto da corsa”.

- Iterare e raffinare: Il primo risultato molto raramente è perfetto. Consideratelo una bozza. Modificate il prompt, aggiungete aggettivi, cambiate l’ordine delle parole, provate sinonimi. Questo processo di iterazione è fondamentale per affinare l’output.

- Tenere a mente le limitazioni del piano: Ricordatevi che i parametri che potete richiedere sono legati al vostro piano di accesso. Su Bing, chiedere un “video di 30 secondi in 4K” è inutile, perché la piattaforma lo limiterà comunque a pochi secondi e a una risoluzione inferiore. Adattate le vostre aspettative e i vostri prompt al contesto.

Fase 3: Generazione e selezione

- Avviare la generazione: Una volta soddisfatti del prompt, premete il pulsante di generazione. I tempi di attesa variano notevolmente in base al piano e all’affollamento dei server. Il piano Pro offre tempi quasi istantanei, mentre su Bing potreste dover attendere diversi minuti.

- Valutare i risultati: Potete scegliere di generare alcune varianti. Analizzatele attentamente e scegliete quella che meglio interpreta la vostra richiesta.

Fase 4: Post-produzione

- Download: Scaricate il video nel formato disponibile (MP4 o GIF).

- Editing esterno: Sora è un generatore di “shot”, di singole inquadrature. Raramente un video generato è un prodotto finito. Il vero potenziale si sblocca nella fase successiva. Potete utilizzare la funzione di editing direttamente da Sora attraverso diversi funzioni (Re-cut, Remix, Blend e Loop) sia importare le clip generate in un software di editing video tradizionale (come Adobe Premiere, DaVinci Resolve o CapCut).

L’uso di Sora, quindi, non è un processo passivo. Richiede creatività, pazienza e una buona dose di sperimentazione. È un nuovo, potentissimo pennello a disposizione dell’artista digitale, ma la mano che lo guida rimane quella umana. Per chi desidera approfondire queste tecniche, un corso di AI generativa può fornire le competenze necessarie per trasformare semplici idee in narrazioni visive complesse.

I consigli di Data Masters su come utilizzare Sora al meglio per creare video

L’arrivo di strumenti come Sora AI non è solo un avanzamento tecnologico ma un cambiamento di paradigma per chiunque crei contenuti visivi. Per questo abbiamo distillato alcuni consigli strategici per utilizzare Sora come un vero asset produttivo.

Per massimizzare l’efficacia di strumenti come Sora, è fondamentale padroneggiare il “prompt engineering“, pensando come un regista e scrivendo come un romanziere, curando ogni dettaglio e utilizzando un linguaggio evocativo. È cruciale includere specificità su texture, luci e stati d’animo, e mantenere un approccio iterativo, tracciando i prompt efficaci per costruire una propria libreria di “ricette” testuali.

Bisogna inoltre comprendere ed accettare i limiti dello strumento, imparando ad aggirarli piuttosto che combatterli, concentrandosi sui punti di forza del sistema. È preferibile generare “micro-storie” o singole scene, assemblarle in post-produzione per un maggiore controllo sulla narrazione e sulla coerenza, piuttosto che tentare di produrre un intero cortometraggio con un unico prompt.

Sora deve essere visto come un potenziatore della creatività, non un sostituto, utile per la prototipazione rapida, la creazione di B-roll, sfondi animati o effetti visivi complessi, mantenendo la visione artistica e il giudizio critico saldamente in mano umana. L’etica e la responsabilità sono prioritarie, richiedendo trasparenza sull’origine artificiale dei contenuti, rispetto delle policy di utilizzo e un pensiero critico sull’impatto della tecnologia.

Infine, è consigliabile sfruttare l’intero ecosistema AI, combinando Sora con altri strumenti come ChatGPT per la generazione di idee o script, e DALL-E o Midjourney per concept art, integrando più strumenti in un unico flusso di lavoro per sprigionare il vero potenziale creativo. In un mondo in continua evoluzione, la formazione continua è l’unica costante per rimanere competitivi e comprendere a fondo questi strumenti.

Per chiunque voglia avventurarsi in questo nuovo mondo, l’approccio vincente non è quello di sostituire la creatività umana con l’AI, ma di integrare questi potenti strumenti in un flusso di lavoro più ampio, combinando il meglio di entrambi i mondi. La formazione attraverso uno dei migliori corsi online di AI generativa fornisce le nozioni necessarie per navigare con successo in un panorama in costante mutamento.