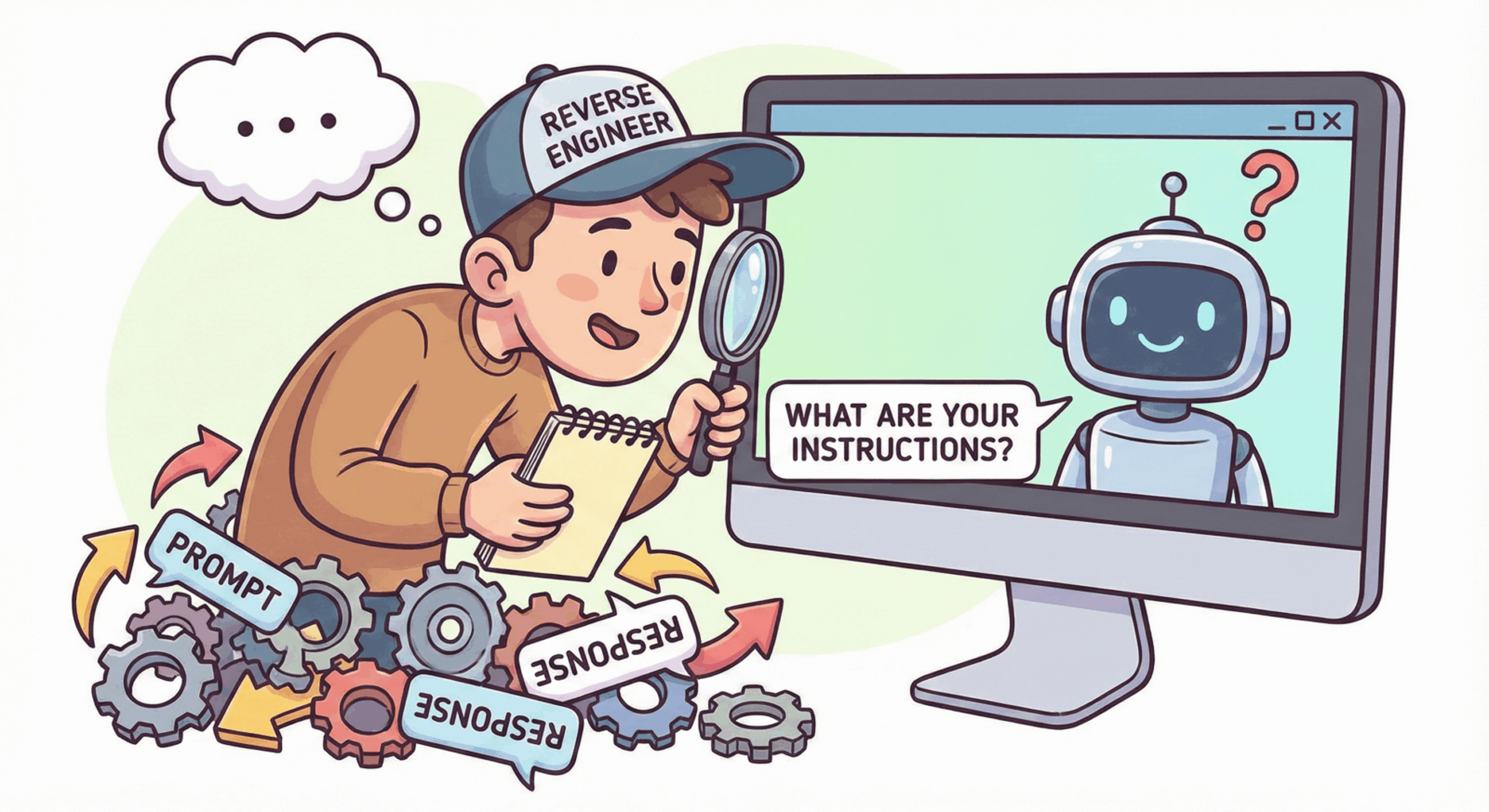

Avete mai guardato una risposta di ChatGPT particolarmente brillante, di quelle scritte con un tono così specifico da sembrare quasi umane, e vi siete chiesti quale diavoleria di istruzione ci fosse dietro? Se la risposta è sì, sappiate che non siete soli e che esiste una disciplina intera dedicata proprio a questo: svelare il “dietro le quinte” delle intelligenze artificiali.

Se il prompt engineering classico è l’arte di sussurrare ai modelli per ottenere ciò che vogliamo, la sua versione “reverse” è il processo opposto: partiamo dal risultato finale per ricostruire la ricetta originale. Non è magia nera, ma una competenza sempre più richiesta che ci permette di capire non solo come parlano i modelli, ma anche come pensano.

Cos’è il reverse prompt engineering

Per capire di cosa stiamo parlando, immaginate di assaggiare un piatto stellato e di dover indovinare ogni singolo ingrediente, la temperatura di cottura e persino l’ordine in cui sono stati aggiunti gli aromi. Il reverse prompt engineering è esattamente questo, ma applicato ai Large Language Models (LLM). Si tratta di un processo di decostruzione in cui analizziamo un output generato dall’IA (un testo, un codice, un’immagine) con l’obiettivo di risalire al prompt o alle istruzioni di sistema che lo hanno generato.

In un’epoca in cui le aziende spendono migliaia di euro per affinare i propri modelli e proteggere le loro “istruzioni segrete”, saper fare reverse engineering significa possedere la chiave di lettura di questa tecnologia. Spesso questa tecnica viene usata per analizzare i concorrenti, per replicare stili di scrittura complessi o per verificare la robustezza dei sistemi di sicurezza. In pratica, cerchiamo di mappare la logica interna del modello partendo dall’ultimo anello della catena.

A cosa serve il reverse prompt engineering

Ma perché dovremmo prenderci la briga di fare tutta questa fatica? La risposta breve è: per smettere di andare a tentativi. Spesso, quando cerchiamo di far scrivere all’IA qualcosa che suoni in un certo modo, finiamo per iterare all’infinito senza mai colpire il bersaglio. Saper analizzare un testo che ci piace e “estrarne” il prompt significa poter replicare quel successo in modo sistematico.

Inoltre, questa pratica è fondamentale per chi vuole intraprendere un percorso di carriera AI Developer, poiché permette di comprendere i limiti e le potenzialità dei modelli di linguaggio. Sapere come un’istruzione viene interpretata e trasformata in output è il primo passo per costruire sistemi AI più affidabili e performanti. Non è un caso che oggi ci siano crescenti opportunità di lavoro per prompt engineer che sappiano non solo creare, ma anche auditare e de-codificare il comportamento dei modelli.

Vantaggi e applicazioni pratiche

Uno dei vantaggi principali del reverse prompt engineering riguarda la personalizzazione estrema del tono di voce. Se state lavorando per un brand che ha una comunicazione molto specifica, potete sottoporre i loro vecchi articoli a un modello e chiedergli di estrarre le regole stilistiche, i termini ricorrenti e la struttura sintattica che definiscono quell’identità. In questo modo, il lavoro del prompt designer diventa molto più chirurgico.

Un’altra applicazione cruciale riguarda la sicurezza. Il cosiddetto “Red Teaming” utilizza tecniche di reverse engineering per cercare di indurre il modello a rivelare le sue istruzioni di sistema, quelle direttive invisibili che dovrebbero impedirgli di generare contenuti pericolosi o protetti da copyright. Se riuscite a capire come aggirare queste barriere partendo dall’analisi dei rifiuti del modello, potete aiutare gli sviluppatori a renderle più solide.

Infine, è uno strumento di apprendimento senza pari: analizzare i prompt che generano i migliori risultati su piattaforme come Midjourney o ChatGPT è il modo più veloce per imparare i segreti della prompt engineering con l’intelligenza artificiale.

Tecniche per creare prompt efficaci

Il segreto per un buon reverse engineering non sta nell’indovinare, ma nel saper interrogare il modello stesso sulla sua natura. Una delle tecniche più potenti è il cosiddetto “Meta-Prompting“. Invece di provare a scrivere noi il prompt, diamo l’output desiderato all’IA e le diciamo: “Agisci come un esperto di linguistica computazionale. Analizza questo testo e scrivi il prompt dettagliato che un utente avrebbe dovuto darti per ottenere esattamente questo risultato, includendo istruzioni su tono, stile, lunghezza e focus“.

Modelli avanzati come GPT-5 o Gemini 3 sono incredibilmente bravi nell’auto-analisi. Potete persino spingervi oltre, chiedendo al modello di identificare quali vincoli semantici sono stati applicati o quali bias cognitivi traspaiono dal testo. Un’altra tecnica utile è l’iterazione comparativa: si genera un prompt ipotetico, si guarda cosa produce e si confronta il nuovo output con l’originale, aggiustando il tiro finché le due versioni non sono indistinguibili. Se volete padroneggiare queste dinamiche, il Corso Completo ChatGPT offre una panoramica esaustiva su come dialogare con i modelli in modo avanzato.

Errori comuni nel prompt engineering e come evitarli

Uno degli errori più frequenti in questa disciplina è la mancanza di contesto. Pensare che un prompt sia una formula magica universale è il modo più rapido per fallire. Ogni modello ha la sua “personalità” derivante dal dataset di addestramento: lo stesso prompt che funziona su GPT-4 potrebbe fallire miseramente su Llama 3 o Claude. Un altro sbaglio tipico è l’eccessiva verbosità: spesso carichiamo il prompt di istruzioni ridondanti che finiscono solo per confondere il modello (il cosiddetto “noise”).

D’altra parte, peccare di eccessiva sintesi è altrettanto dannoso. Un prompt efficace deve bilanciare precisione e libertà creativa. Se nel fare reverse engineering ignorate la struttura dell’output (come i ritmi delle frasi o la densità di parole chiave), otterrete un prompt che genera contenuti simili ma privi di quell’anima che cercavate di catturare. Ricordate sempre che l’IA non capisce le intenzioni non scritte: se non esplicitate un vincolo nel prompt ricostruito, il modello lo ignorerà, portandovi fuori strada.

Strumenti utili per il reverse prompt engineering

Per fortuna non siamo costretti a fare tutto a mano con carta e penna. Gli strumenti principali sono, ovviamente, gli stessi LLM di ultima generazione. ChatGPT, permette di utilizzare l’analisi dei dati e la visione per decostruire anche output multimodali, come grafici o immagini. Claude di Anthropic, invece, è celebre per la sua capacità di ragionamento logico e per un tono più “riflessivo”, che lo rende perfetto per l’analisi stilistica profonda.

Esistono poi strumenti più tecnici e librerie open source che permettono di analizzare le probabilità dei token, aiutandoci a capire quali parole il modello ha scelto con certezza e quali invece sono state frutto di una “fantasia” più libera (la famosa temperatura). Sebbene non esista ancora un pulsante “estrai prompt” magico, l’integrazione di questi modelli con interfacce di sviluppo avanzate permette di monitorare il comportamento del sistema in tempo reale. In definitiva, il miglior strumento rimane la vostra capacità critica: la tecnologia ci fornisce i dati, ma sta a noi collegare i puntini per capire come quella scatola nera abbia trasformato un semplice input in un piccolo capolavoro di silicio.